Les leaders de l’IA s’engagent à protéger les enfants en ligne… Trop tard ?

Publié le

24 avril 2024 à

09h29

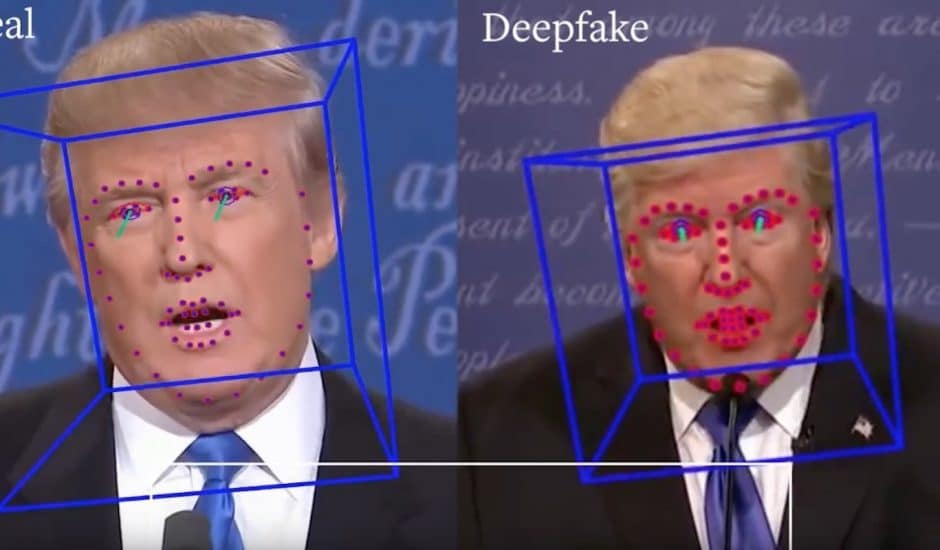

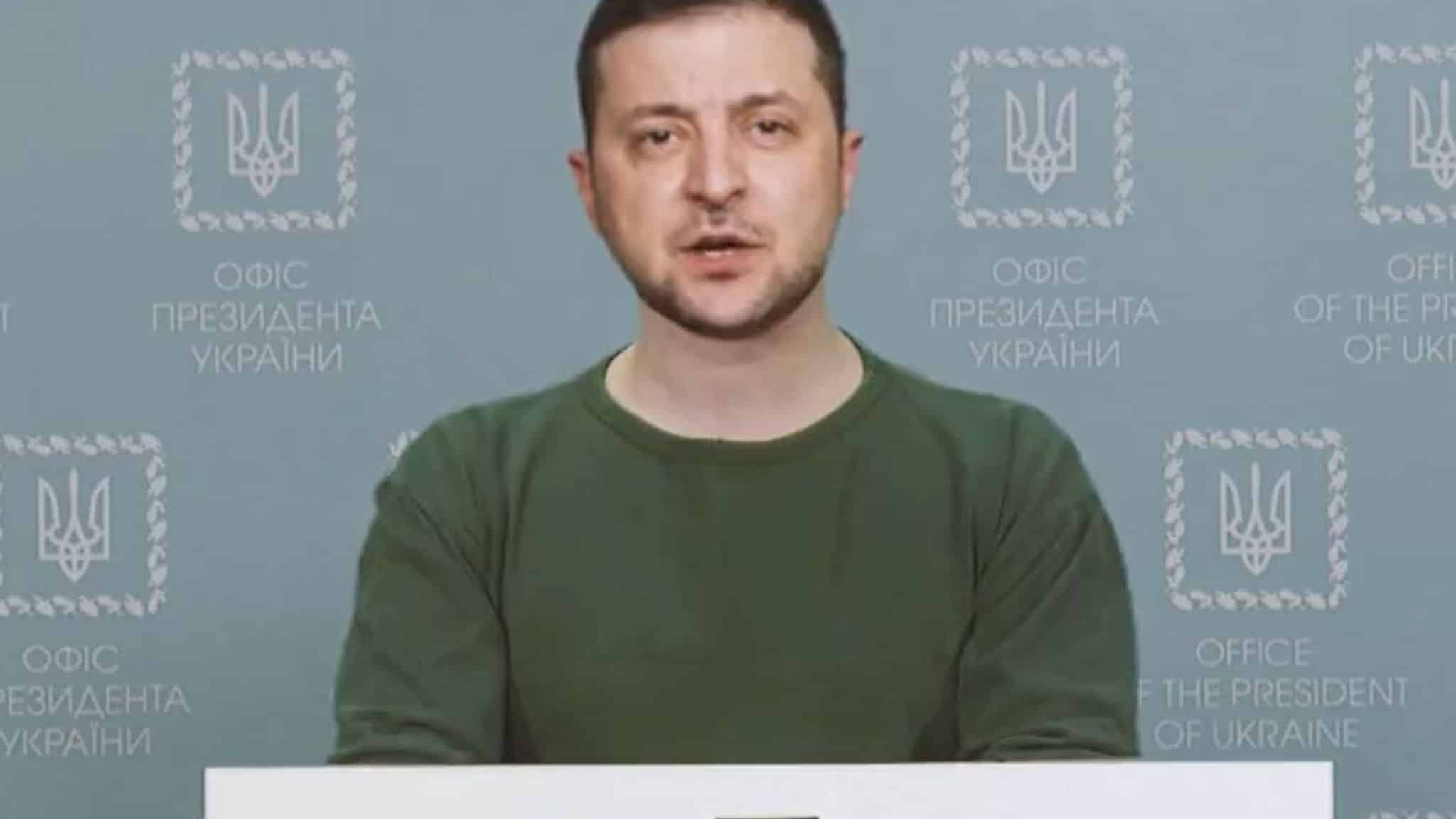

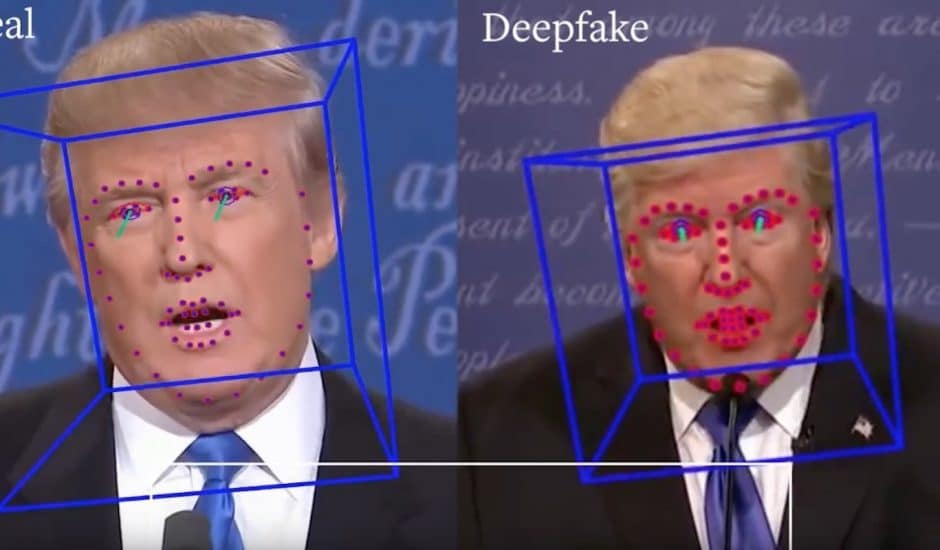

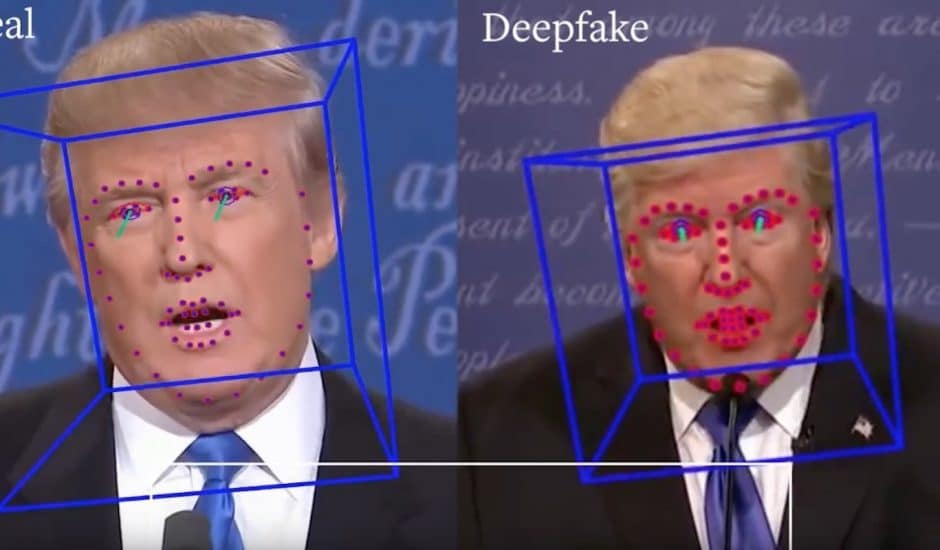

Les utilisations nocives de l'intelligence artificielle générative pour altérer le processus démocratique inquiètent.

La plateforme a réduit ses efforts de modération sous l’égide d’Elon Musk…

Opinion

Opinion  Sponsorisé

Sponsorisé