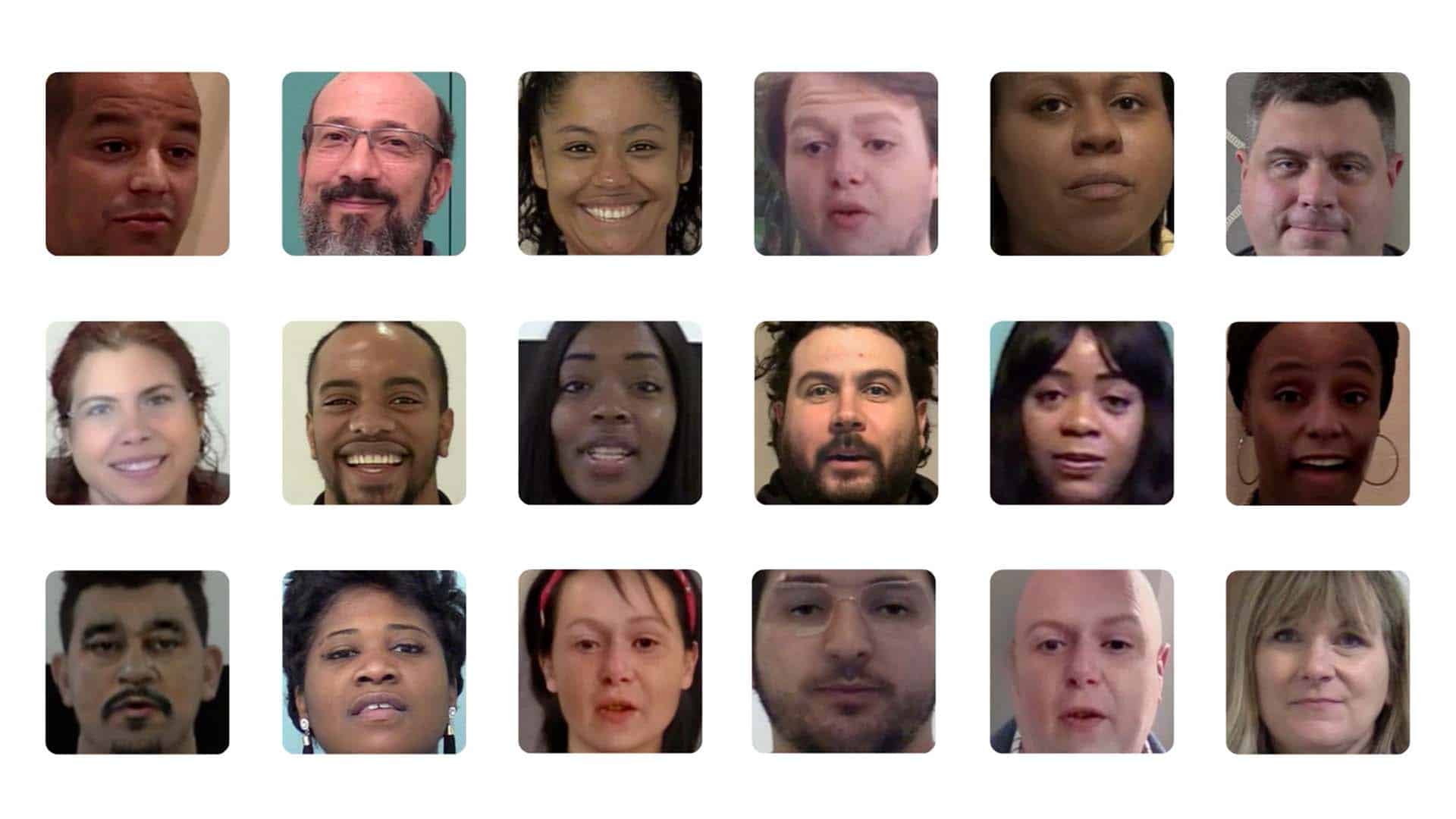

Les deepfakes, perfectionnés et plus accessibles avec l’émergence de l’IA générative, inquiètent au plus haut point. Plus de 500 chercheurs et experts appellent à leur stricte réglementation dans une lettre ouverte.

Criminaliser les deepfakes pédopornographiques

« Les deepfakes constituent une menace croissante pour la société et les gouvernements doivent imposer des obligations tout au long de la chaîne d’approvisionnement pour mettre fin à leur prolifération », préviennent-ils. La situation est d’autant plus préoccupante que de nombreuses élections auront lieu à travers le monde cette année.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

En janvier, un deepfake audio de Joe Biden incitant des électeurs américains à ne pas se rendre aux urnes pour les primaires démocrates a particulièrement alerté les experts. Il s’agit d’un exemple parmi tant d’autres du potentiel impact de cette technologie sur les processus démocratiques. De même, la recrudescence de deepfake pornographiques et pédopornographiques doit être stoppée à travers des mesures fortes, préconisent les signataires.

Ils appellent à la criminalisation totale de ce type de contenu mettant en scène des enfants, que les personnages représentés soient réels ou fictifs. Des sanctions pénales devraient également être instaurées pour ceux qui créent ou diffusent des deepfakes nuisibles, poursuivent-ils. Les développeurs sont aussi incités à empêcher leur création, et devraient être pénalisés si leurs mesures de prévention sont inadéquates.

L’UE tente de légiférer, les États-Unis plus mesurés

La parution de cette lettre intervient alors que l’Union européenne cherche à agir pour contrer le problème, par exemple en identifiant tous les contenus générés par l’intelligence artificielle. Les législateurs souhaitent également rendre les deepfakes pornographiques pénalement répréhensibles.

Outre-Atlantique, la prolifération de fausses images de Taylor Swift sur X, anciennement Twitter, a récemment alerté la classe politique. Washington reste néanmoins mesurée dans son encadrement de l’IA, mettant surtout la pression sur les entreprises pour en mitiger les risques. Cette semaine, une task force a été annoncée avec la mission d’établir un rapport sur les menaces liées à l’IA et sur les moyens de les limiter sur le plan législatif.

« Étant donné que l’IA progresse rapidement et qu’il est beaucoup plus facile de créer des deepfakes, des garanties sont nécessaires », indiquent les signataires de la lettre. Parmi eux, se trouvent notamment des chercheurs de Google DeepMind et un employé d’OpenAI.

Une lettre similaire, signée par des milliers de grands noms comme Elon Musk, appelait l’année dernière à une interruption temporaire des recherches dans l’IA générative. Objectif, mieux évaluer les risques pour s’en prémunir plus efficacement. Personne n’a appliqué cette recommandation.