2024 propose un cocktail au potentiel détonnant : un mélange entre démocratisations de l’IA générative et une vague impressionnante de scrutins électoraux à travers le monde. En première ligne sur le sujet, OpenAI a pris l’initiative dans un billet de blog publié le 15 janvier de présenter sa politique pour sécuriser l’utilisation de ses outils au cours des campagnes.

Le spectre des fake news sur une année électorale historique

L’élection présidentielle et législative de Taïwan le 13 janvier, n’est pas la première de 2024 et très loin d’en être la dernière. Quelque 77 élections à portées nationales vont avoir lieu au cours de l’année. États-Unis, Royaume-Uni, Corée du Sud, Afrique du Sud, Inde… Ce n’est qu’un petit échantillon des pays où les citoyens vont être appelés aux urnes. Sans omettre les élections européennes de juin.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

Les rumeurs et fausses nouvelles ont toujours plus ou moins existé au cours des campagnes électorales, mais les « fake news » se sont imposées comme un sujet de préoccupation majeur au milieu des années 2010. Si l’ère des réseaux sociaux a été signalée propice à leur propagation, celle des IA génératives est encore plus redoutée.

Les outils de générations de textes, d’images et de vidéos peuvent représenter des armes de désinformation massives. OpenAI, en tant que précurseur et propriétaire des outils les plus populaires, est particulièrement exposé à cette problématique. L’organisation a fait savoir qu’elle s’efforce à « prévenir les abus, assurer la transparence sur les contenus générés par l’IA et améliorer l’accès à des informations fiables sur le vote ».

Dans sa publication elle dévoile plusieurs dispositifs à venir, censés limiter le risque. Les images générées par DALL-E devraient être encodées pour pouvoir retracer leur provenance. Une expérimentation pour détecter les images créées par l’IA va être menée. Enfin, ChatGPT doit devenir de plus en plus transparent sur les sources de ses réponses sur l’actualité. OpenAI discute justement une série d’accords avec de grands médias internationaux.

L’entreprise a également rappelé certaines de ses règles. Les applications basées sur ses technologies ne peuvent pas servir à une campagne politique, de lobbying, à dissuader les gens de voter.

Un peu de fébrilité chez OpenAI

Le texte d’OpenAI semble tout de même laisser transparaître une certaine fébrilité, lorsqu’il admet que « Comme toute nouvelle technologie, ces outils comportent des avantages et des défis ». Il est reconnu en creux que les équipes de sécurité, « pluridisciplinaire », apprennent à mesure que les cas d’utilisations se présentent.

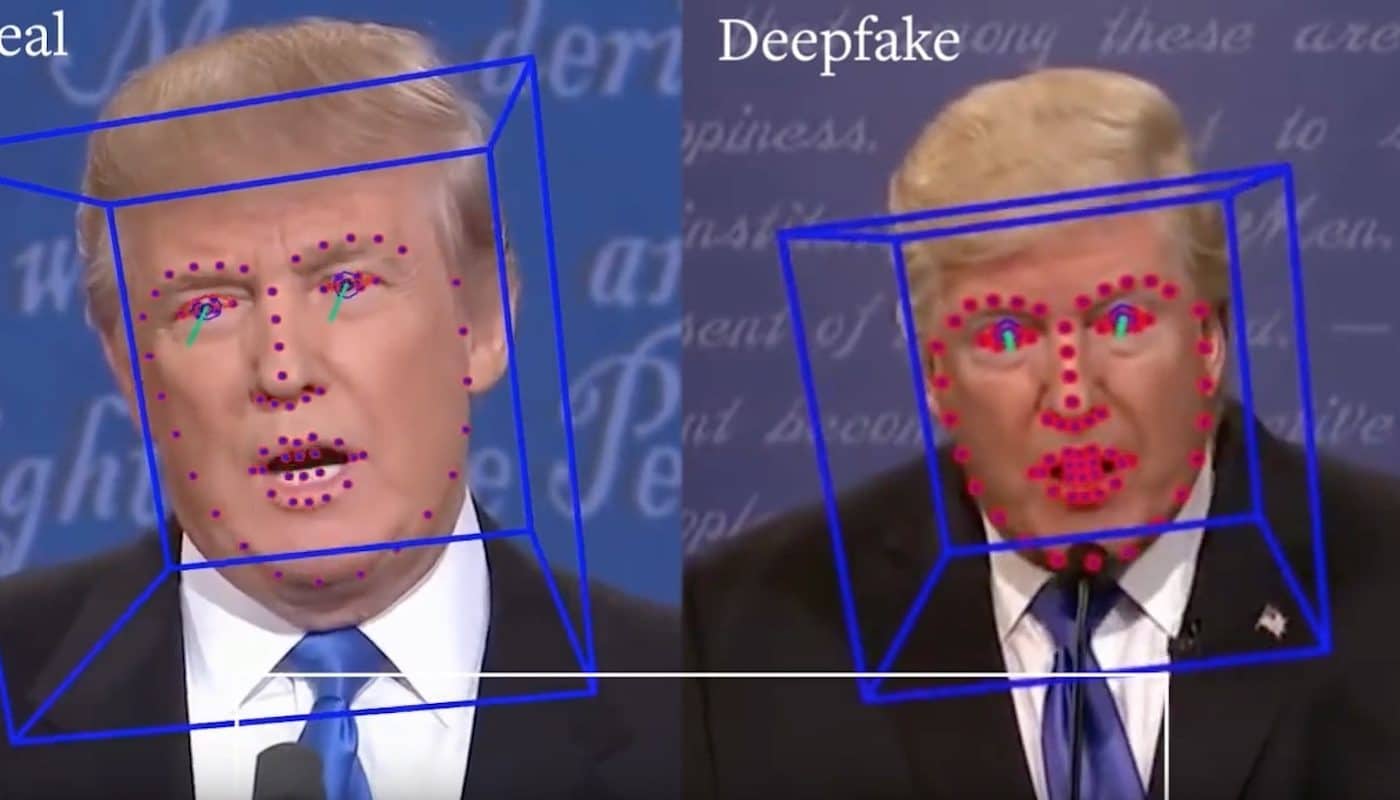

Néanmoins, ces dernières sont mobilisées « pour enquêter et traiter rapidement les abus potentiels » assure la société. Elle précise également s’efforcer à anticiper et prévenir les risques les plus importants que sont les deepfakes, les opérations d’influences à grande échelle ou les chatbots se faisant passer pour des candidats.