L’année 2023 sera celle de la singularité technologique, le moment où des intelligences artificielles commenceront subitement à s’autonomiser changeant radicalement la société humaine. Il ne reste plus que quelques semaines pour que ce pronostic établi dans un livre de 1993 par Vernor Vinge, auteur de science-fiction de formation scientifique, se réalise. Dans les faits et malgré les performances de ChatGPT, sorti publiquement il y a un an, nous en sommes loin. Pourtant, cette crainte et ses différentes variantes, comme l’intelligence artificielle générale, reviennent régulièrement sur le devant de la scène. Au risque d’occulter, parfois, les dangers bien concrets de l’IA.

De la science à la science-fiction, à la science

Les 1er et 2 novembre, le Royaume-Uni a organisé un grand sommet sur la sécurité de l’IA à Bletchley Park, là où Alan Turing a cassé le code Enigma. Le ton du rendez-vous a été donné par Rishi Sunak, Premier ministre, peu avant le début de la rencontre. Auprès de journalistes il s’est inquiété, « sans vouloir être alarmiste », que l’IA « pourrait présenter des risques à une échelle telle que les pandémies ou une guerre nucléaire ». Une formulation proche d’un texte succinct du Center for AI Safety, publié quelques mois plus tôt et signé par de grands noms de la tech, comme Sam Altman, Bill Gates et autres dirigeants d’entreprises ou chercheurs de divers domaines dont l’IA.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

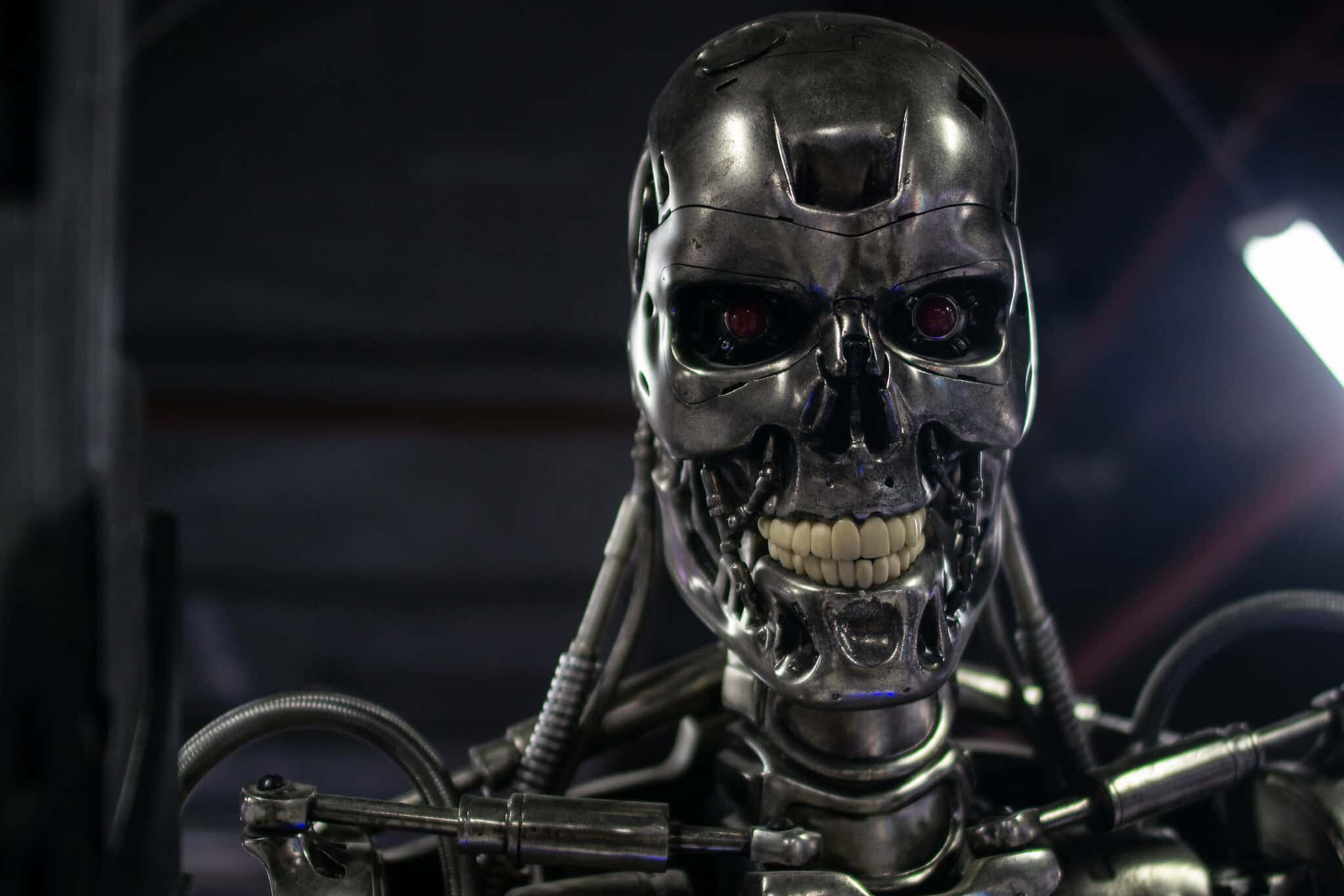

Sans y faire explicitement référence, ces propos apocalyptiques renvoient à divers concepts dont la singularité ou l’IA générale sont au cœur. L’idée qu’une intelligence artificielle surpasse en tout point l’être humain et ne finisse par le détruire. Ces prises de paroles ne sont pas nouvelles. Pendant qu’Alan Turing évoquait tout juste l’apprentissage automatique, à la fin des années 40, le célèbre écrivain Isaac Asimov explorait déjà dans ses nouvelles la possibilité d’une émancipation, ou non, de robots. L’intelligence artificielle elle-même ne naît officiellement qu’en 1955. Le cinéma est rempli de ces machines qui tendent à l’autonomie. Si certains films, comme Her, imaginent une autonomisation des IA pacifique, l’image catastrophique d’un Terminator ou d’un Matrix domine.

Crédit : Daniel Oberhaus / Flickr

Ces théories ont trouvé et trouvent toujours des adeptes bien au-delà du monde de l’imaginaire. En 2014, l’éminent savant Stephen Hawking a pris la plume pour alerter les humains de la voie dangereuse qu’il commençait à emprunter. Elon Musk, présent au sommet britannique, fait partie de ces personnalités qui s’alarment régulièrement du sujet. Sa peur serait même à la source de plusieurs de ses investissements. Son biographe, Walter Isaacson, raconte que les tentatives du milliardaire pour mettre la main sur la start-up d’IA DeepMind étaient en partie motivées par la volonté d’en priver Larry Page, de Google, dont les idées en matière d’IA lui semblaient dangereuses. Neuralink vise explicitement à façonner un humain capable de rivaliser avec l’IA. Il a cofondé OpenAI en opposition à DeepMind. La mention, précoce dans l’ouvrage d’Isaacson, d’Asimov parmi les références de jeunesse de Musk n’est pas innocente.

Avec les technologies d’aujourd’hui, l’IA rebelle n’est pas à l’ordre du jour

Ces théories sur l’autonomisation de l’IA redoutée par des milliardaires de la tech, des ingénieurs et scientifiques de renoms, suscitent tout autant de scepticisme voire de méfiance. Jean-Gabriel Ganascia, professeur émérite à Sorbonne Université, s’est fendu d’un essai au titre évocateur, Le mythe de singularité. Ce chercheur en intelligence artificielle et spécialiste des questions d’éthiques écrit que « rien dans l’état actuel des techniques d’IA n’autorise à affirmer que les ordinateurs seront bientôt en mesure de se perfectionner indéfiniment sans le concours des hommes, jusqu’à s’emballer, nous dépasser et acquérir leur autonomie ». L’auteur s’agace d’un changement de paradigme. Dans les années 50 à 80, la science-fiction s’inspirait de théories scientifiques pour alimenter ses histoires, aujourd’hui ces histoires alimentent les réflexions de chercheurs.

Depuis la publication de l’ouvrage de Jean-Gabriel Ganascia, une nouvelle technologie occupe le devant de la scène : l’IA générative. Un succès populaire qui entretient les angoisses. Pourtant, « ChatGPT, pour nous, scientifique, ce n’est pas une révolution. La science qu’il y a derrière n’est pas nouvelle. Depuis 10, 15 ans, c’est à peu près le même cadre de pensée qui est utilisé » fait remarquer à Siècle Digital Sylvain Petitjean, chargé de mission auprès du président de l’Institut national de recherche en sciences et technologies du numérique (Inria) pour la création d’une instance nationale de réflexion sur l’éthique de la recherche en sciences du numérique. Il partage les doutes sur l’hypothèse d’une IA générale menant l’humanité à son extinction au niveau technologique actuel. Ancien président du Comité opérationnel d’évaluation des risques légaux et éthiques de l’Inria, le chercheur regrette que « ce narratif soit arrivé dans la bouche des politiques, porté par les grands industriels de la tech ». Il y voit « une erreur fondamentale » amenant « à oublier tout le reste ».

Le cynisme comme moteur d’une peur fantasmée ?

Les journalistes couvrant le sommet sur la sécurité de l’IA ont témoigné des discussions difficiles ayant abouti à la Déclaration de Bletchley, signée par les 28 États représentés. Au putatif risque existentiel de l’IA, mis en avant par le gouvernement britannique, d’autres souhaitaient et sont parvenus à mentionner les dangers bien concrets, actuels de cette technologie.

La vice-présidente des États-Unis, Kamala Harris, ne cachait pas, en amont de la rencontre, sa frustration sur le cadre initial proposé par Rishi Sunak, « soyons clairs : il existe d’autres menaces qui exigent également notre action. Des menaces qui causent actuellement du tort et qui, pour beaucoup de gens, semblent également existentielles ». La vice-présidente américaine a cité le « revenge porn » à partir de photo truquée par IA, les biais discriminants et leurs conséquences dans la société, ou la création de fausses informations plus vraies que nature. On pourrait ajouter la question de la confidentialité des données ou du droit d’auteur.

De l’avis de Sylvain Petitjean, la focale sur le scénario abstrait d’une IA menaçant l’humanité par son autonomie est une diversion des grands groupes. Ces derniers financent, par ailleurs, largement les recherches dans ce domaine. Tout d’abord cela leur permet de se poser comme seules organisations avec les compétences techniques pour empêcher la catastrophe. Pour cela, elles doivent avoir les mains libres, s’autoréguler. Ensuite, questionner des menaces lointaines permet d’éviter de s’interroger sur les actuels. Enfin, « dans la façon dont ces technologies ont été lâchées dans la nature. Il y a une forme d’irresponsabilité, de ces géants de la tech, parce que c’est puissant, parce que ce n’est pas maîtrisé ». Le déferlement de l’IA générative dans l’espace public, lancé par OpenAI et suivi par ceux, comme Google, qui jusque-là se montraient plus prudents, a été réalisé dans la précipitation, sans les garde-fous nécessaires.

Un encadrement des États semble donc nécessaire. Problème, comme le montre l’AI Act de l’Union européenne, le texte en la matière le plus avancé dans son processus législatif, réglementer prend du temps. Il a été présenté par la Commission européenne en 2021 et son adoption rencontre encore des difficultés. À contrario, avec l’IA, « Nous sommes sur des technologies qui ont des cycles de développement très court, avec des innovations sur des cycles extrêmement rapides » pointe Sylvain Petitjean. « Dans l’intervalle, comment est-ce que nous rapprochons les technologies et les valeurs de la société ? C’est là où l’éthique entre en jeu, nous allons essayer de confronter les avances de la science et des technologies, avec les valeurs de la société, les valeurs fondamentales ».