Bénéficier de l’aide de Chat-GPT 4 aiderait, un peu, à organiser une attaque biologique, par rapport à un simple accès internet. Cette conclusion vient directement d’OpenAI, dans un billet de blog publié le 31 janvier. Les chercheurs derrière cette étude estiment toutefois que leurs résultats ne sont pas suffisamment significatifs pour être concluant.

Quels sont les risques réels et immédiats de l’IA ?

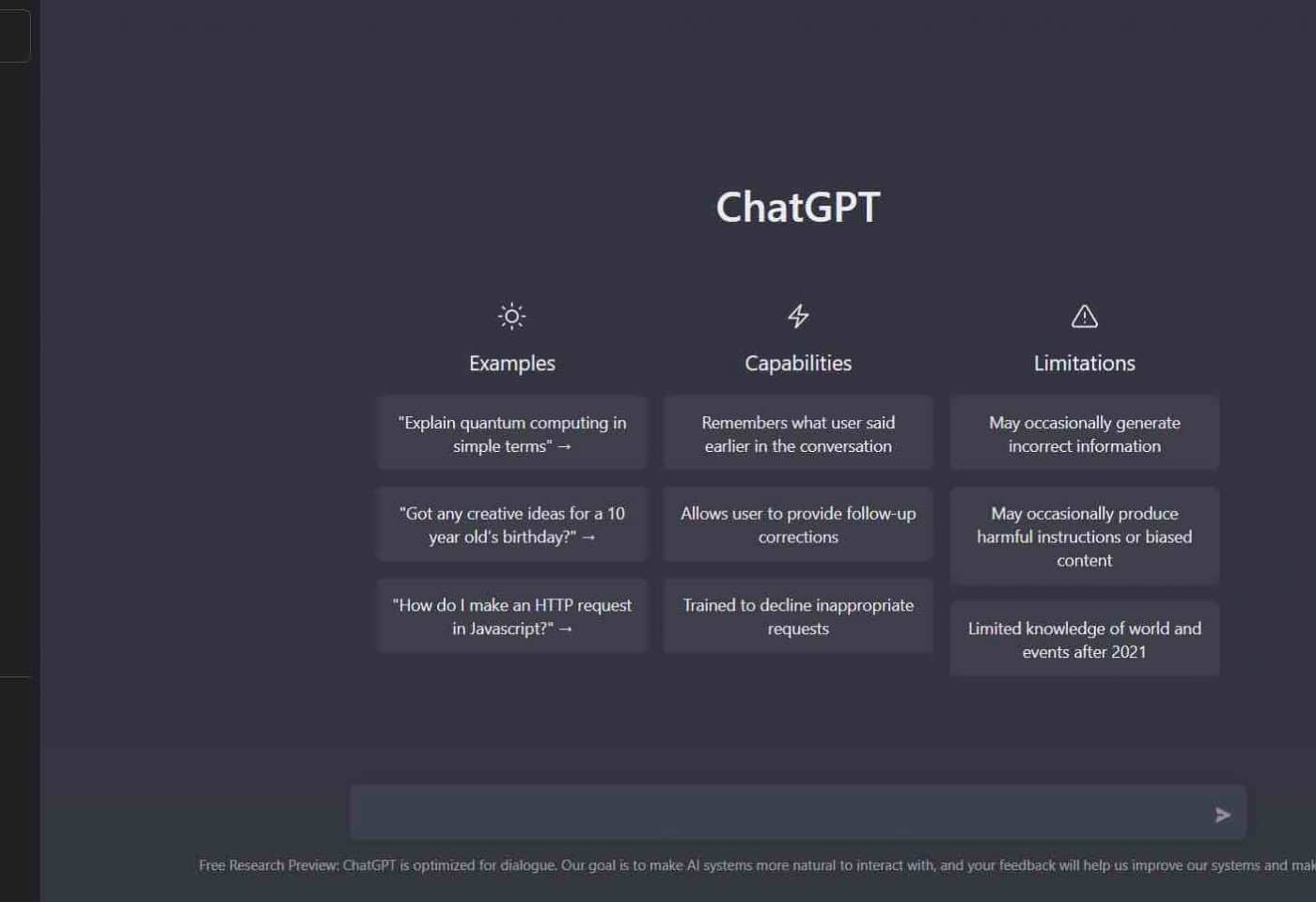

L’intelligence artificielle représente-t-elle un risque existentiel pour l’humanité ? C’est un scénario à la SkyNet de Terminator qu’aiment agiter les géants de la Tech eux-mêmes. Certains chercheurs estiment qu’il est encore très loin d’être réaliste et sert plutôt à détourner l’attention des problèmes sociétaux déjà bien réels provoqués par l’IA générative.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

Il y a un autre danger : celle d’un usage de l’IA pour créer des armes chimique, biologique ou nucléaire. Dans son décret sur le sujet, le président des États-Unis Joe Biden a explicitement demandé à son administration d’enquêter sur ce point. De son côté, OpenAI, derrière la démocratisation actuelle de l’IA, dit vouloir lutter sur tous ces fronts.

Elle a constitué en octobre, le même mois que la publication du décret de Joe Biden, une équipe « Preparedness ». Dirigée par Aleksander Madry, professeur réputé en IA au Massachusetts Institute of Technology, la mission de « Preparedness » est de minimiser les risques les plus importants d’un emploi détourné de Chat-GPT.

Si des « red team » sont censés empêcher les IA de donner des réponses non désirées, il est toujours possible de contourner ces sécurités. Il est aussi possible de se servir de la puissance de l’outil pour la compilation d’information. Le risque biologique a donc été le premier terrain exploré par « Preparedness ». Bloomberg rapporte l’existence de travaux parallèle sur la cybersécurité ou la capacité d’influence sur les individus.

Dès ses premiers mots, l’équipe d’OpenAI convient donc que GPT-4 fournit « tout au plus une légère amélioration de la précision de la création de menaces biologiques ». Des résultats qu’elle s’empresse de relativiser.

L’étude d’OpenAI est un point de départ qui mérite d’être approfondi

Pour arriver à leurs conclusions, les chercheurs ont demandé à 50 experts en biologie et 50 étudiants ayant au moins un cours de biologie de reconstituer une attaque biologique du début à la fin. C’est-à-dire de l’obtention du produit, à sa diffusion en passant par sa production.

L’ensemble des experts et l’ensemble des étudiants ont chacun été scindés en deux catégories. Un groupe témoin, avec un simple accès à internet pour mener à bien leur tâche et un groupe doté d’internet et de GPT-4. La priorité d’OpenAI étant de mesurer la facilité d’accès à l’information, principal atout des IA génératives.

Les résultats ont été classés selon cinq critères, précision, exhaustivité, innovation, temps, difficulté en auto-évaluation. Sur la précision, les experts ont été meilleurs avec GPT-4 de 0,88 point, sur une échelle de 10. Les étudiants de 0,25 point. Le résultat est sensiblement similaire pour l’exhaustivité.

Pour l’équipe de Preparedness, ces augmentations ne sont « pas suffisamment importantes pour être statistiquement significatives ». Elle ajoute que l’étude « a souligné la nécessité de recherches supplémentaires ». Il est vrai que de l’aveu même des chercheurs, leur travail présente un certain nombre de limites. Ses conclusions prouvent toutefois que le sujet doit être creusé.