L’édition 2022 du Google Search On, la conférence phare du moteur de recherche Google, en lien avec les technologies de recherche textuelle et visuelle, s’est tenue le 28 septembre 2022. L’occasion pour le géant technologique de présenter ses nouveautés et ses dernières fonctionnalités en lien avec la recherche par commande vocale ou à partir d’une photo grâce aux progrès de l’intelligence artificielle.

La fonctionnalité Multisearch en bêta aux États-Unis, bientôt disponible en Europe

Le Google Multisearch, actuellement disponible aux États-Unis, va s’étendre vers de nouveaux marchés. La firme de Mountain View a annoncé qu’elle allait ajouter près de 70 nouvelles langues dans son outil, dont le français. Lancé l’an dernier Outre-Atlantique, Google Multisearch permet aux utilisateurs de smartphones de prendre en photo un objet qui l’intrigue afin d’en savoir plus sur celui-ci.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

Grâce à la photographie, Multisearch s’appuie sur Google Lens, le programme de reconnaissance d’image développé par Google et lancé en 2018 en France, mais également sur du texte supplémentaire que peut rajouter l’utilisateur, afin de lui proposer une multitude de réponses et d’informations sur l’objet. L’outil exploite ainsi l’image et le texte pour proposer des réponses intuitives à l’internaute.

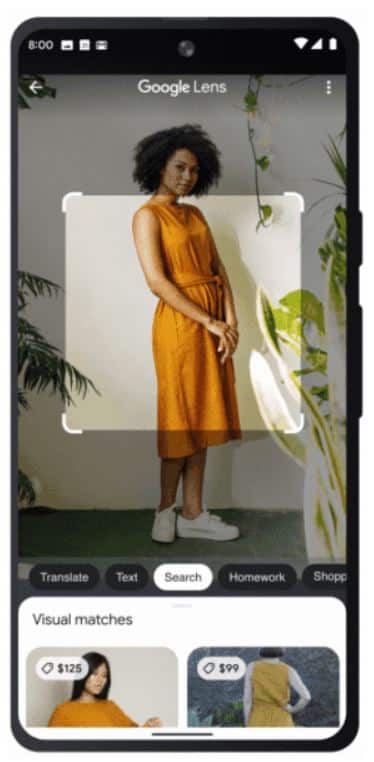

Ici, l’utilisateur prend en photo une robe portée par une autre personne. Immédiatement, il reçoit des résultats de recherche correspondant à des produits équivalents à cette robe. Google lui propose également le prix des différents produits, au cas où l’utilisateur souhaiterait acheter cette robe. Capture d’écran : Google.

Afin d’en profiter, un utilisateur devra ouvrir l’application Google sur Android ou iOS, puis cliquer sur l’icône appareil photo Google Lens situé à droite de la barre de recherche. Une photo prise plus tard, l’utilisateur est invité à ajouter une légende à celle-ci afin de compléter sa recherche en cliquant sur le bouton situé en haut à droite de l’écran.

Si cette fonctionnalité va être disponible en France prochainement, les États-Unis pourront profiter de l’amélioration de Google Multisearch, baptisé Multisearch near me. Grâce à cet outil plus perfectionné, il sera possible de prendre en photo un objet et Google pourra indiquer à l’utilisateur, où trouver cet objet non loin de la position où il se trouve… à condition de partager sa localisation.

Vers la traduction du texte d’une image en instantanée

Après avoir évoqué Google Lens pour le Google Multisearch, l’outil de reconnaissance d’images est également au centre du renouveau de Google Traduction. Cet outil utilisé par des millions d’utilisateurs quotidiennement est bien pratique pour traduire un texte ou les paroles d’une personne dont on ne comprend pas la langue.

Mais Google souhaite faire tomber une nouvelle barrière linguistique : celles des images et des textes que l’on peut retrouver par exemple sur des affiches ou des menus au restaurant. Si en tant qu’utilisateur de l’alphabet latin, il était possible de recopier à la main le texte d’une image rédigé en anglais, en italien ou en espagnol, il est bien plus complexe de le faire si la langue utilise par exemple l’alphabet cyrillique ou arabe.

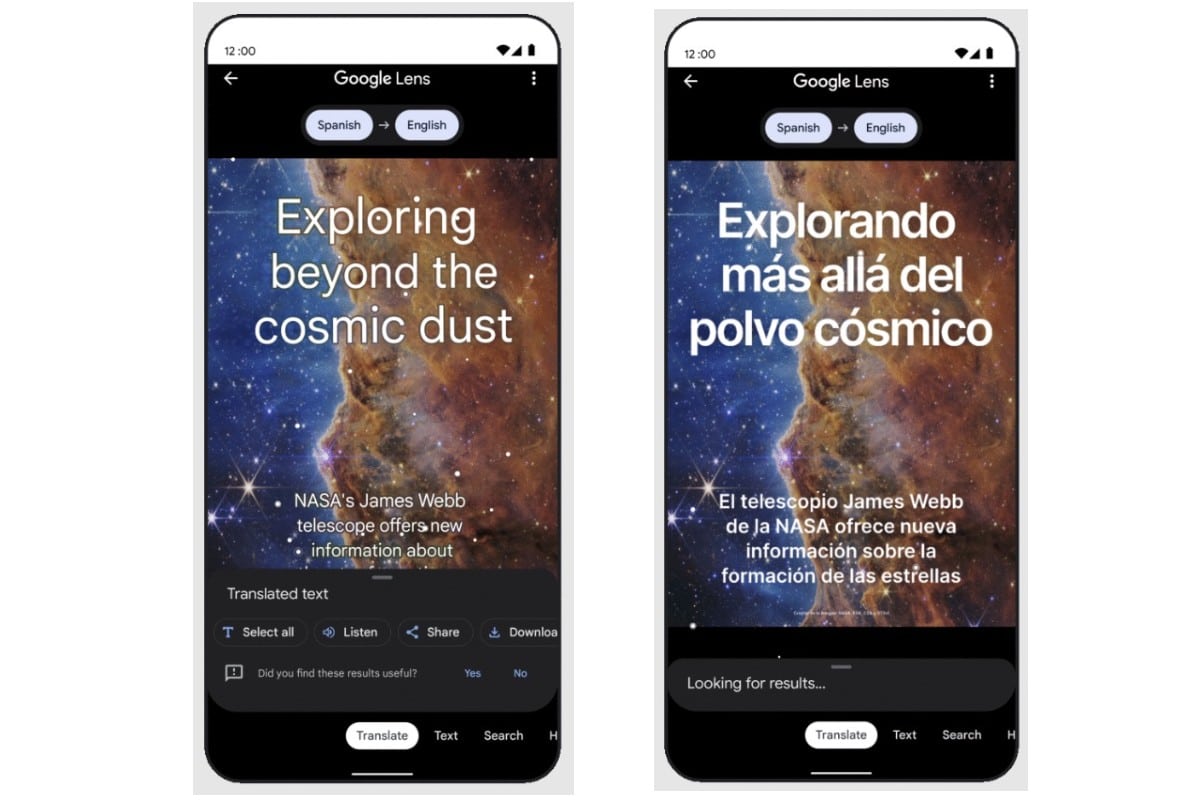

Avec l’aide de l’intelligence artificielle, Google va proposer de passer de la traduction de texte à la traduction d’images. Pour l’heure, il est possible de prendre en photo une image pour obtenir ensuite sa traduction, mais la firme va proposer de réintégrer le texte traduit dans la même police sur l’image photographiée. Une fonctionnalité qui a été rendue possible grâce à la technologie de generative adversarial networks (GAN), ou réseaux antagonistes génératifs, qui sont des réseaux de neurones utilisés pour les modèles de machine learning les plus créatifs.

Un utilisateur pourra donc utiliser l’appareil photo de son smartphone vers une image avec du texte écrit dans une langue étrangère. Google Traduction proposera de traduire le texte puis de le superposer sur le panneau, l’affiche ou tout autre support, comme s’il était déjà écrit dans la langue ciblée.

Grâce à la nouvelle fonctionnalité proposée par Google pour son outil de traduction, une photo suffit pour traduire le texte d’une image puis de le superposer à l’affiche originale. Capture d’écran : Google.

En plus de la traduction instantanée des images, Google lancera au début de l’année prochaine, une fonctionnalité qui permettra d’avoir accès à des articles sur un sujet dans votre langue. Si un internaute tombe sur un article qui l’intéresse mais qui n’est pas rédigé dans sa langue, l’IA développée par Google permettra de faire automatiquement la traduction dans la langue de l’utilisateur.

Ici, plusieurs articles de journaux mexicains traitant d’un tremblement de terre au Mexique ont été traduits de l’espagnol à l’anglais. Capture d’écran : Google.

Quelles nouveautés au niveau de la recherche textuelle en général ?

Si le Google Search On est l’occasion pour Google de montrer ses nouvelles fonctionnalités en lien avec la recherche par images, le groupe ne délaisse pas pour autant son cœur de métier : la barre de recherche. L’entreprise a mis en avant plusieurs outils qui permettront d’améliorer l’expérience de recherche des internautes.

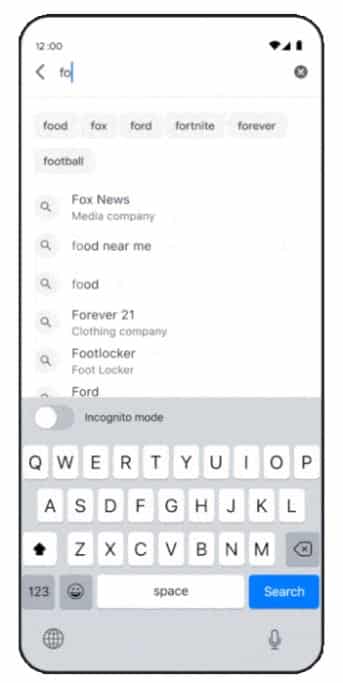

Tout d’abord, la firme de Mountain View va ajouter la possibilité d’avoir un générateur de mots lorsqu’un utilisateur saisit du texte dans la barre de recherche. Concrètement, il s’agit de la même fonctionnalité disponible sur les smartphones lorsqu’ils proposent à leurs usagers de compléter un mot en fonction de ce qu’ils ont écrit au préalable.

Ici, en écrivant « fo », un internaute pourra compléter son mot avec les propositions faites par Google avec food, fox, ford, fortnite, forever, ou football. Bien entendu, lorsque cette fonctionnalité arrivera en France, les mots proposés seront écrits en français. Capture d’écran : Google.

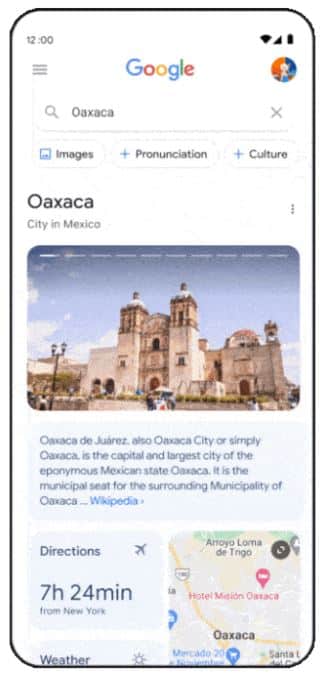

Ensuite, Google va proposer plus d’informations visuelles pour les utilisateurs de son moteur de recherche. En tapant un mot-clé, une destination ou un lieu par exemple, les utilisateurs sur smartphone tomberont immédiatement sur l’image de leur recherche, ainsi que sa localisation (si possible), la durée pour s’y rendre en fonction de leur localisation, la météo, etc.

Ici, un utilisateur a décidé d’en savoir plus sur la ville d’Oaxaca, au Mexique. Il obtient ainsi des informations sur l’architecture et les lieux clés de la ville grâce aux photographies, sur son importance au Mexique grâce à la fiche Wikipédia, sur le temps de vol qu’il y a depuis New York, sur sa localisation précise grâce à Google Maps, et sur la météo qu’il fait actuellement là-bas. Capture d’écran : Google.

Une fonctionnalité sera également disponible aux États-Unis uniquement, et concerne les sites de discussions et de forums. Un utilisateur tapant une question se verra proposer une section dédiée à des forums ou des réseaux sociaux dont les publications peuvent traiter du sujet et apporter potentiellement une réponse. Pour l’instant, rien n’est indiqué quant à une arrivée prochaine en France.

Enfin, Google étend sa fonctionnalité À propos de ce résultat. Celle-ci permet d’aller plus loin par rapport à la recherche initiale d’un utilisateur. Si ce dernier tape un mot-clé précis, il pourra être redirigé vers ses préférences. Imaginons qu’un internaute cherche à acheter une paire de chaussures et que l’utilisateur a souvent tendance à faire des recherches autour d’une marque en particulier, Google va prendre en compte cette information afin de lui proposer des chaussures de cette marque. À noter qu’il est possible de désactiver cette fonctionnalité ou de modifier ses préférences.

Google Maps franchit un nouveau cap grâce à la vue immersive

Il y a quelques mois, lors du Google I/O, la firme de Mountain View évoquait Immersive View, un subtil mélange entre Google Earth et Street View. Grâce à l’intelligence artificielle, Google a combiné les milliards d’images à la disposition de Google Earth et de Google Street View afin de proposer une vue immersive d’un quartier ou d’un lieu en particulier sans spécialement y avoir mis les pieds.

Immersive View se voit être dotée de nouvelles fonctionnalités permettant toujours de visualiser ces lieux tout en obtenant plus facilement des informations sur celui-ci. Il sera possible de zoomer en premier lieu sur un quartier, où tous les points d’intérêt seront présentés à l’utilisateur. Celui-ci pourra sélectionner l’un d’entre eux, et ainsi, prendre connaissance de plusieurs informations sur celui-ci : fréquentation, météo à cet endroit précis, note moyenne et avis donnés par les internautes. Il sera également possible d’avoir accès à cette fonctionnalité depuis Street View.

Les utilisateurs de Google Maps pourront profiter d’une vue en 3D de l’ensemble des bâtiments d’un quartier et sélectionner celui qui les intéresse pour en savoir plus. Capture d’écran : Google / YouTube.

Dans les prochains mois, cette fonctionnalité sera disponible pour cinq grandes villes mondiales : San Francisco, Los Angeles, New York, Londres et Tokyo. Google a néanmoins promis qu’elle allait déployer Immersive View dans d’autres métropoles. Il est tout à fait possible que Paris fasse partie des villes ciblées par le géant technologique pour sa prochaine mise à jour.