Pour aider la division Reality Labs de Facebook qui travaille sur des projets de lunettes intelligentes, de réalité augmentée et de réalité virtuelle, un nouveau projet de recherche a été lancé. Du nom d’Ego4D, son objectif principal consiste à collecter des milliers d’heures de séquences vidéo filmées à la première personne afin de former des modèles d’IA toujours plus innovants.

Construire une base de données vidéo de qualité pour aider la recherche

Tout juste après avoir présenté un modèle d’IA intitulé AVT qui pourrait s’avérer très utile pour des lunettes intelligentes, Facebook annonce dans un billet de blog, son nouveau projet de recherche : Ego4D. Comme expliqué par la firme, si des appareils comme de nouvelles lunettes connectées voient le jour, elles devront se sensibiliser à la perception visuelle d’un être humain. C’est pourquoi Facebook s’intéresse à la collecte de séquences vidéo filmées à la première personne où des individus réalisent des tâches quotidiennes.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

« Traditionnellement, un robot apprend en faisant des choses dans le monde ou en étant littéralement tenu à la main pour qu’on lui montre comment faire les choses », explique Kristen Grauman, chercheuse en chef chez Facebook à CNBC. Avec ces nouvelles images, les chercheurs espèrent pouvoir former une IA qui comprenne ou identifie un objet ou une action dans le monde réel, vu à la première personne.

A gauche, la vision par ordinateur analyse avec succès la séquence prise à la troisième personne mais échoue pour ce qui est de la vidéo filmée à la première personne. Capture d’écran : Facebook.

Les chercheurs souhaitent compiler une base de données complète permettant à leurs modèles de posséder cinq fonctionnalités bien précises. La première est la mémoire épisodique où l’IA se souvient de l’emplacement de certains objets ou de tâches déjà réalisées qu’elle a pu voir. Il y a aussi la prévision : faire en sorte que le modèle puisse réaliser certains processus en respectant des étapes tout en étant préventif. L’interaction main-objet et les interactions sociales sont aussi évoquées tout comme la faculté d’associer les évènements, les personnes et les objets aux sons et bruits qu’ils peuvent produire. Des fonctions soutenues par les projets d’innovation du Reality Labs, notamment sur l’usage de lunettes intelligentes associées à un bracelet.

Près de 2 200 heures de séquences vidéo filmées à la première personne

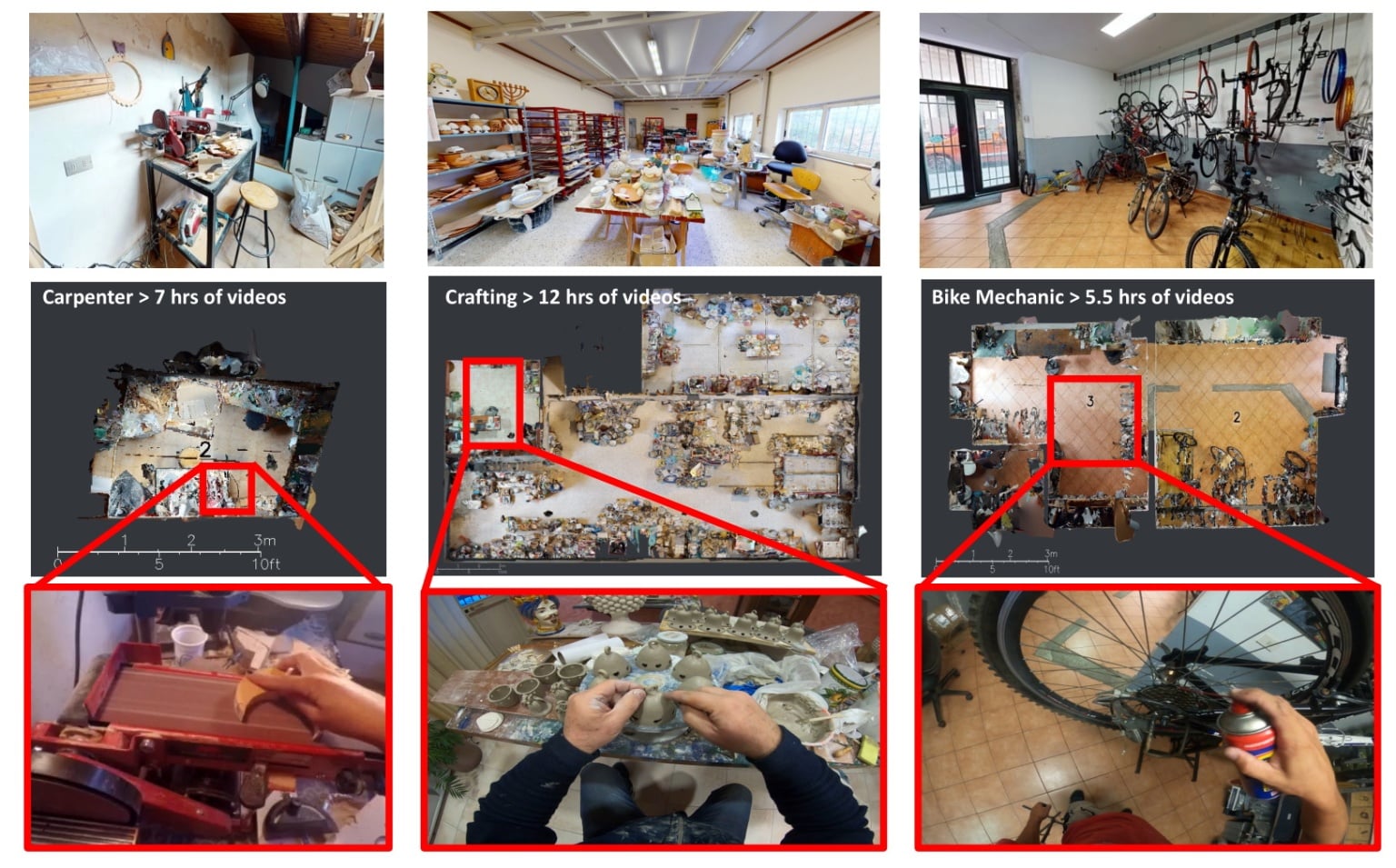

Carnegie Mellon, l’Université de Bristol, l’Université nationale de Singapour, l’Université de Tokyo et l’Institut international des technologies de l’information d’Inde ont pris part au projet. Avec l’aide de 13 universités partenaires au total, des milliers d’heures de vidéo ont été collectées auprès de plus de 700 participants dans neuf pays. Les images ont notamment été capturées aux États-Unis, au Royaume-Uni, en Italie, en Inde, au Japon, à Singapour, et en Arabie saoudite, principalement grâce à des GoPro. Facebook espère étendre le projet à d’autres pays dont le Rwanda et la Colombie.

Après la collecte, une équipe de recherche a annoté chacune des vidéos une par une et les meilleures ont été conservées. En tout, on comptabilise près de 2 200 heures de prises de vue à la première personne. « Nos recherches sont fortement motivées par des applications en réalité augmentée et en robotique » précise Kristen Grauman.

Une récolte de données dans le respect de la confidentialité

Selon le laboratoire de recherche de la société, Ego4D possède 20 fois plus de séquences que tout autre ensemble de données de ce type. « Par rapport aux ensembles de données existants, l’ensemble de données Ego4D offre une plus grande diversité de scènes, de personnes et d’activités, ce qui augmente l’applicabilité des modèles formés pour les personnes de tous horizons, ethnies, professions et âges », ajoute la firme.

Pour des raisons de confidentialité, Facebook a déclaré que les participants avaient pour instruction d’éviter de capturer des caractéristiques d’identification personnelles. Cela inclut les visages, les conversations, les tatouages et les bijoux des gens. Facebook a déclaré avoir supprimé les informations personnellement identifiables des vidéos et flouté les visages des passants et les numéros de plaque d’immatriculation des véhicules. L’audio a également été supprimé de la plupart des vidéos, a indiqué la société.