Des chercheurs de Tencent ont découvert un piège facilement réalisable qui peut faire rouler en sens inverse les voitures Tesla exploitant une version du mode « Autopilot » antérieure à 2017 avec grande facilité. Pour cela, pas besoin de pirater les systèmes de la machine, nous relate ArsTechnica. Il suffit de placer de petits stickers, qui, bien qu’invisibles par le conducteur, sont traités par le système de conduite autonome comme une indication de changement de voie. Heureusement, les voitures Tesla ont besoin de l’accord du conducteur pour effectuer une telle manoeuvre, ce qui ne mettait pas leurs possesseurs en danger.

Le pilotage automatique de la Tesla, pour fonctionner, s’appuie sur tout un tas de capteurs qui recueillent des informations sur l’environnement routier et les transmettent aux ordinateurs de bord, qui prennent en temps réel les meilleures décisions de conduite par le biais du machine learning. C’est en voulant tester la qualité de ces processus automatisés dans un environnement anormal que les chercheurs du Keen Security Lab de Tencent ont découvert une faille remarquable, mais ancienne.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

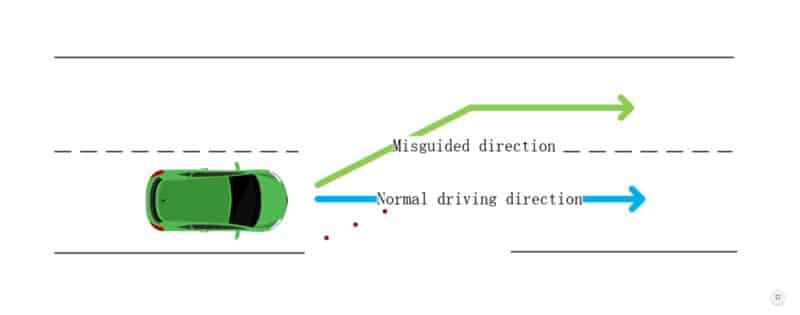

En formant une ligne horizontale pointant vers la gauche à l’aide de trois stickers, ils ont poussé l’Autopilot d’une Tesla Model S 75 à vouloir se déporter sur la voie de gauche, en sens inverse. Tout simplement car les algorithmes de machine learning traitaient les stickers comme une indication que la voie se déplaçait dans cette direction.

Une image illustrant la déportation de la voiture par l’effet des stickers © Keeen Security Lab

Dans un rapport détaillé de 37 pages, les chercheurs ont indiqué que cette faille, peu dangereuse (du fait de la nécessité de l’aval du conducteur), mais facilement exploitable, pourrait être corrigée en développant la reconnaissance de voie à l’arrière du véhicule. En effet, si la voiture sait par le biais de capteurs à l’arrière, que ses capteurs à l’avant l’envoi sur une route où l’on roule en sens inverse, il prendra la bonne décision et évitera un accident de la circulation. Les chercheurs ont aussi pointé d’autres faiblesses minimes, comme le fait qu’il était possible de déclencher les essuie-glace de la Tesla par temps sec.

Dans une réponse à ce rapport, Tesla a déclaré qu’elle avait développé un programme de bug-bounty précisément pour avoir des feedback de ce type. Seulement, elle rajoute que les résultats véritablement compromettants ont été obtenus dans « des scénarios ou l’environnement physique du véhicule était artificiellement modifié » et que dès lors « ce n’était pas une préoccupation réaliste étant donné qu’un conducteur peut facilement neutraliser le pilote automatique à tout moment ». Tesla rajoute tout de même qu’elle apprécie les efforts extraordinaires du groupe, et qu’elle a hâte de voir ses futurs travaux.Surtout, elle précise que ces bugs n’existent plus depuis que deux mises à jour en 2017 et en 2018 ont permis la correction du problème.

En conclusion, vous pouvez profiter en toute tranquillité de l’Autopilot, fraichement débarqué sur les Tesla Model 3 en Europe au mois de février. Ce dernier n’a pas fini d’évoluer, et s’est notamment fait remarquer pour sa capacité à reprendre le contrôle après un dérapage sur du verglas il y’a peu.

Mise à jour : Il y’avait plusieurs erreurs dans cet article. Nous y annoncions que l’Autopilot n’était pas disponible sur les voitures Tesla livrées en Europe, alors qu’il ne l’était pas uniquement sur les Tesla Model 3, de plus ces dernières l’intègrent à leur tour depuis février 2019. Autre chose, la version de l’Autopilot testée par les scientifiques était antérieure à 2017, car deux mises à jour sorties respectivement cette année là et l’année suivante, en 2018, ont corrigé la faille citée par les chercheurs. Dans l’article original, nous parlions de « dernière version ».