Si les précédentes études sur le sujet montraient que le trafic provenant des IA était encore très anecdotique, la tendance est-elle en train de changer ?

Selon le dernier rapport Global Bot Security Report 2025 de DataDome et accessible publiquement, cette tendance, désormais structurelle, redéfinit la manière dont le web fonctionne et soulève de sérieuses questions de cybersécurité…

1,7 milliard de requêtes en un mois

Un aperçu des chiffres du mois d’août – Source : DataDome

En 2025, d’après le rapport de DataDome, le trafic des robots d’indexation et des agents IA aurait quadruplé, si bien qu’ils représentent désormais plus de 10% des requêtes.

Rien que pour les robots d’OpenAI, près de 1,7 milliard de requêtes ont été détectées sur le mois d’août. Cette intensification traduit un basculement : l’IA n’est plus une anomalie, mais un élément central du trafic web.

📩 L’actu digitale évolue vite. Restez à jour.

Recevez la newsletter quotidienne, gratuitement.

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

Toutefois, comme on pouvait le pressentir avec des projets comme Comet, le problème ne se limite pas au volume. En effet, les nouveaux agents IA imitent le comportement humain, génèrent des navigateurs à la volée, et contournent même les Captchas.

Malheureusement, leur mode de fonctionnement pourrait rendre inutilisables les systèmes de cyberdéfenses classiques, si bien que les entreprises ne savent plus toujours distinguer un trafic de véritables visiteurs de celui de potentielles menaces.

Des sites toujours plus exposés…

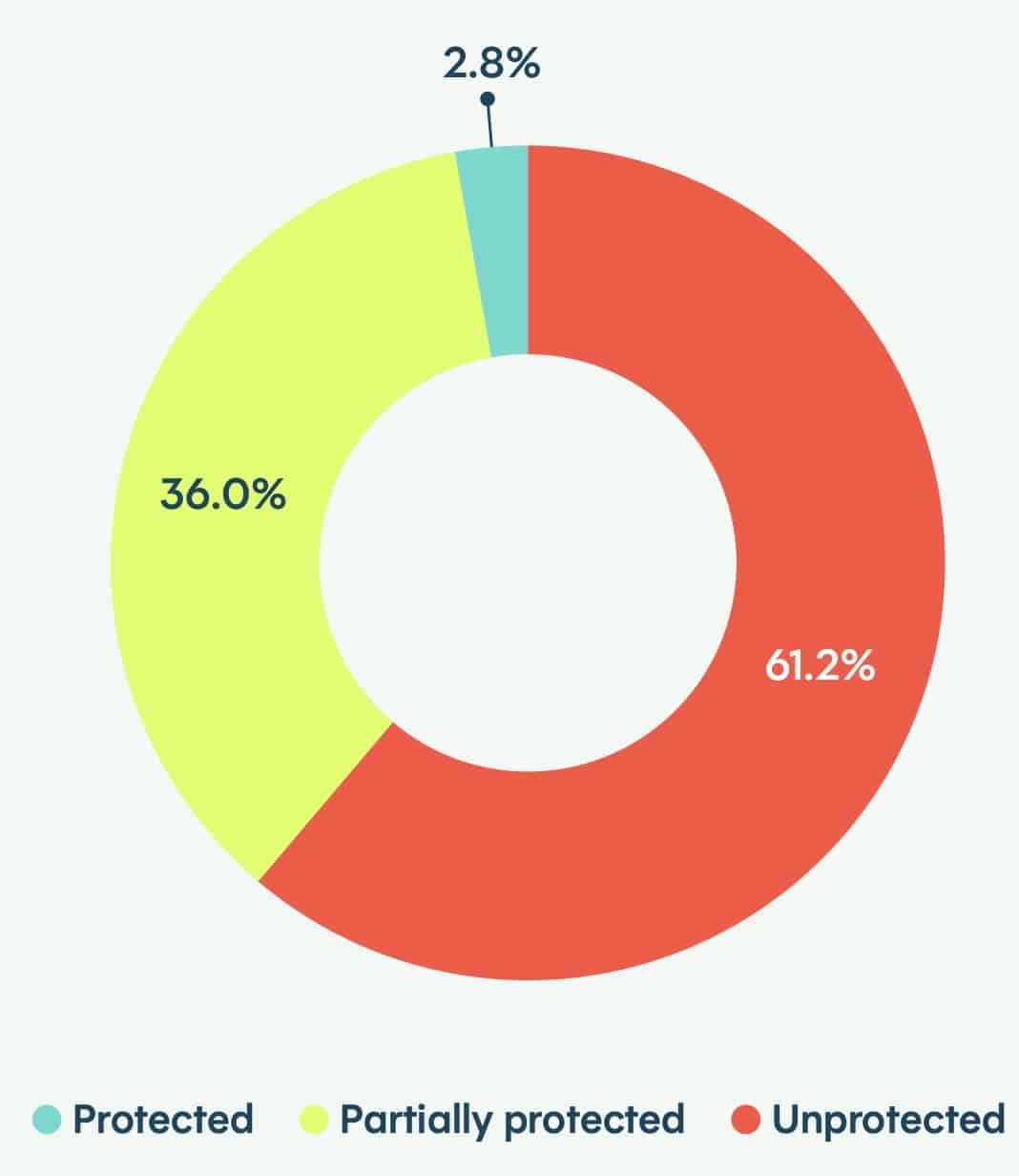

Des chiffres préoccupants pour la cybersécurité… – Source : DataDome

Malgré la prise de conscience de cette tendance, les grandes entreprises peinent à renforcer leurs protections. L’étude révèle que seuls 2,8% des sites analysés sont protégés, contre 8,4% l’an passé.

Même les grandes plateformes restent vulnérables, et parmi les sites dépassant les 30 millions de visites mensuelles, seuls 2% sont correctement sécurisés.

Le phénomène touche particulièrement les terminaux critiques, où 64% du trafic piloté par des bots IA atteint les formulaires, 23% les pages de connexion et 5% les flux de paiement. De quoi multiplier les risques de fraude et de prise de contrôle de comptes…

En France, certaines disparités apparaissent selon les secteurs. Le bâtiment tire son épingle du jeu avec 23% de sites totalement protégés, quand la santé et les jeux-vidéo affichent un retard préoccupant.

Une transformation durable d’Internet

Pour Jérôme Segura, vice-président de la recherche chez DataDome, le défi dépasse la seule cybersécurité : « Les entreprises doivent apprendre à gérer ce double enjeu : se protéger des menaces sophistiquées tout en exploitant les opportunités offertes par le trafic généré par l’IA ».

Aujourd’hui, le constat est clair : les stratégies de défense doivent évoluer rapidement, car les outils traditionnels ne suffisent plus face à des agents capables de brouiller la frontière entre automatisation et interactions humaines. Le web, et plus généralement internet, semble se diriger dans une nouvelle ère où l’IA est à la fois un moteur d’innovation et une source de risques inédits…