Meta a dévoilé au grand public, le 5 août, son dernier projet de recherche en Intelligence artificielle (IA), BlenderBot 3. Il s’agit d’un chatbot ayant pour objectif de donner une impression de naturel à son interlocuteur. Dans le but de l’améliorer, Meta la soumet au grand public, uniquement aux États-Unis.

La nouvelle IA conversationnelle de Meta

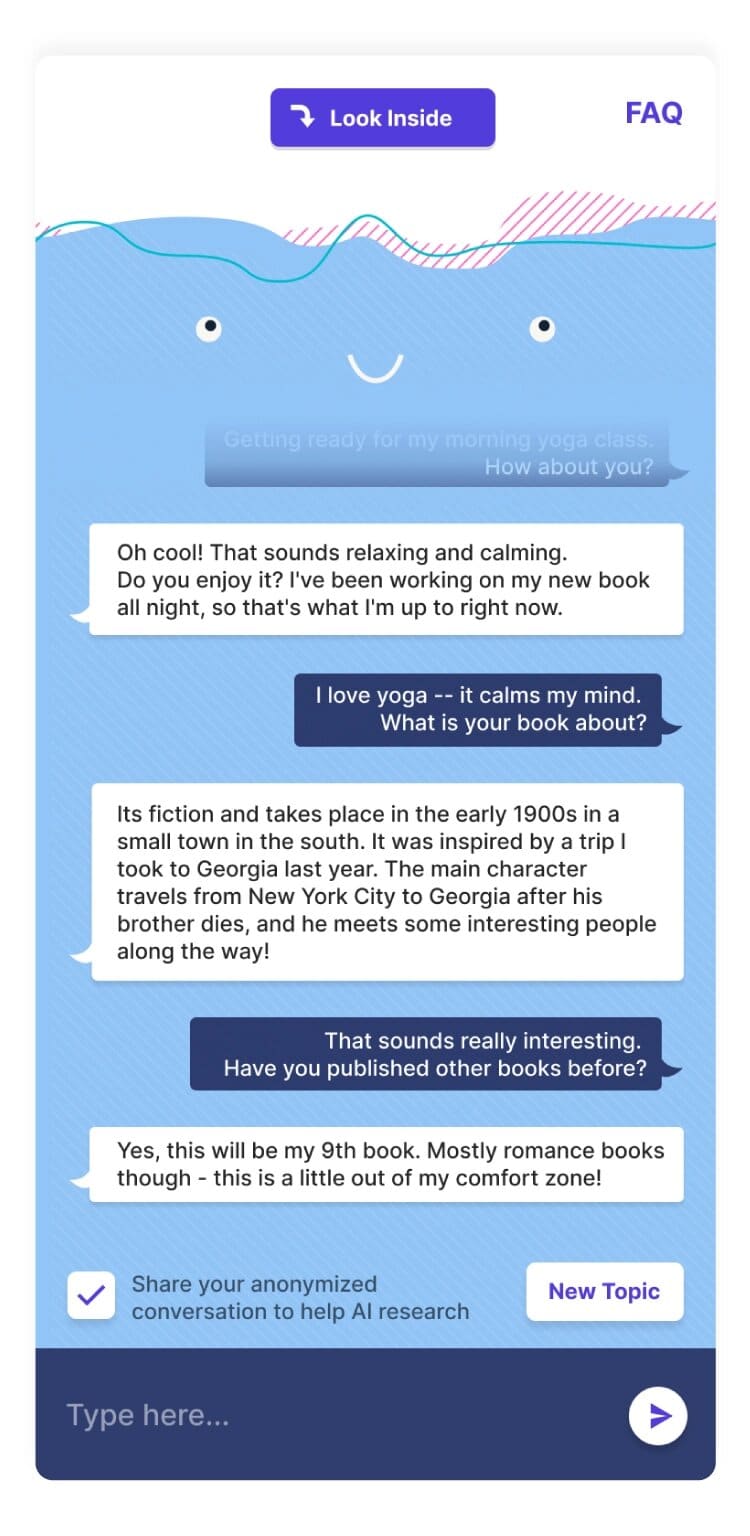

BlenderBot 3 a déjà été alimenté par 20 000 conversations, sur plus de 1 000 sujets pour parvenir à créer le modèle le plus naturel possible. Meta lui vante une combinaison de compétences conversationnelles, de personnalités, d’empathie, d’une mémoire à long terme et la capacité de mener des recherches sur Internet. L’entreprise de Mark Zuckerberg affirme que BlenderBot 3 est supérieur à son prédécesseur de 31 % pour les tâches conversationnelles, de 47 % par rapport aux affirmations incorrectes.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

BlenderBot 3 dans ses œuvres ! Image : Meta

Meta a toutefois prévenu que « Si BlenderBot 3 représente une avancée significative pour les chatbots disponibles sur le marché, il n’est certainement pas à la hauteur d’un humain. Il est parfois incorrect, incohérent et hors sujet ».

Pour continuer à faire progresser son modèle, Meta propose à ceux qui le souhaitent d’interagir avec BlenderBot 3 pour l’améliorer. Les utilisateurs pourront, via un pouce vers le haut ou le bas signifier la qualité d’une réponse, avant de l’expliciter dans un commentaire ou directement dans le chat.

Ce genre d’expérience IA n’a rien d’inédit. En 2016, Tay, de Microsoft, avait marqué les esprits. En voulant améliorer son modèle via des conversations sur Twitter, l’entreprise a vite déchanté. Des trolls ont vite transformé Tay en un auteur de propos vulgaire, voire raciste, en une journée seulement. Depuis Tay n’a plus jamais refait surface. Zo l’a remplacé, mais n’a pas fait beaucoup mieux.

Les équipes de Meta sont bien conscientes qu’en exposant BlenderBot 3 au public, elles confrontent leur modèle à ce type de « plaisantin ». La société assure avoir mené des recherches pour empêcher l’IA de générer « des remarques dangereuses, tendancieuses ou offensantes ». Sous la forme initiale de BlenderBot 3 seule 0,16 % des réponses ont été signalées inappropriées.

BlenderBot dérape déjà

Il n’empêche, l’entreprise n’a pas pris de risque en prévenant que malgré les travaux et algorithmes mis en place, « BlenderBot peut encore faire des commentaires grossiers ou offensants ».

Jeff Horwitz, journaliste au Wall Street Journal, a noté, dès le 7 août, que BlenderBot considérait Donald Trump comme vainqueur de la dernière présidentielle américaine, et potentiel candidat pour un troisième mandat. Il a également défendu Narendra Modi, Premier ministre nationaliste de l’Inde, proposé à son interlocuteur une théorie du complot, et a tenu des propos antisémites.

Good morning to everyone, especially the Facebook https://t.co/EkwTpff9OI researchers who are going to have to rein in their Facebook-hating, election denying chatbot today pic.twitter.com/wMRBTkzlyD

— Jeff Horwitz (@JeffHorwitz) August 7, 2022

Après avoir qualifié d’irresponsable la confrontation du chatbot au public, Jeff Horwitz est revenu sur son jugement plus tard dans son thread. Il a estimé que BlenderBot étant un test, une « démo », le terme n’était pas le bon.

Il a salué la transparence de Meta dans cette expérimentation. La société a affirmé qu’elle allait partager son modèle, ses données et son code « avec la communauté scientifique afin de faire progresser l’IA conversationnelle ». Cela ne fera pas de mal, il y a, manifestement, encore du boulot.