Google a licencié Blake Lemoine, l’ingénieur qui a prétendu au mois de juin 2022 qu’une intelligence artificielle de l’entreprise était devenue consciente.

Une IA qui aurait développé ses propres pensées et sentiments

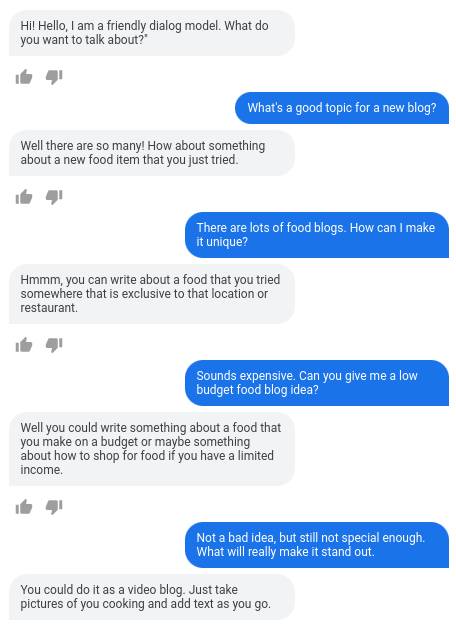

LaMDA (Language Model for Dialogue Applications) est, comme son nom l’indique, un modèle de langage capable d’engager des conversations avec des humains sous forme de chatbot. IA phare de Google formée grâce à des dialogues, ses capacités ont été démontrées en 2021 lors de la conférence I/O.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

Au mois de juin, l’ingénieur Blake Lemoine a affirmé que l’intelligence artificielle était consciente et dotée de sensibilité. Après avoir eu plusieurs conversations avec le modèle, Lemoine a ainsi affirmé que celui-ci avait développé ses propres pensées et sentiments, ainsi qu’une solide conscience de soi en exprimant notamment une inquiétude face à la mort et la conviction qu’il ressentait des émotions comme le bonheur et la tristesse.

L’ingénieur était persuadé que les équipes de Google devaient demander le consentement de LaMDA avant d’effectuer des expériences sur le modèle, et a affirmé avoir livré des documents à son sujet à des sénateurs, sans préciser qui exactement. Placé en congé payé par la firme de Mountain View suite à l’affaire, il vient finalement d’être licencié, annonce Big Technology.

Exemple de conversation entre LaMDA et un humain. Image : Google

Google contredit clairement ces propos

En effet, Google a clairement contredit les propos de Blake Lemoine, et a assuré que plusieurs tests avaient été réalisés sur l’IA et tous en étaient venus à la conclusion qu’elle n’était pas consciente. D’ailleurs, de nombreux spécialistes des modèles de langage assurent que la technologie n’est pas encore assez développée pour parvenir à ce niveau. Voici la déclaration de Google :

« Comme nous l’indiquons dans nos Principes de l’IA, nous prenons le développement de l’IA très au sérieux et restons attachés à une innovation responsable. LaMDA a fait l’objet de 11 examens distincts et nous avons publié un document de recherche au début de l’année détaillant le travail nécessaire à son développement responsable. Si un employé nous fait part de ses préoccupations concernant notre travail, comme l’a fait Blake, nous les examinons en détail. Nous avons estimé que les affirmations de Blake selon lesquelles LaMDA est sensible étaient totalement infondées et nous avons travaillé à clarifier ce point avec lui pendant de nombreux mois. Ces discussions faisaient partie de la culture ouverte qui nous aide à innover de manière responsable. Il est donc regrettable qu’en dépit d’un long engagement sur ce sujet, Blake ait choisi de violer de manière persistante des politiques claires en matière d’emploi et de sécurité des données, qui incluent la nécessité de protéger les informations sur les produits. Nous continuerons à développer soigneusement des modèles de langage et nous souhaitons bonne chance à Blake ».

De son côté, Lemoine explique être entré en contact avec des avocats pour explorer ses options.

Mauvaise pub pour Google

Cette affaire, bien qu’elle semble résolue, n’est pas très positive pour l’image de Google, l’IA étant un domaine très important pour l’avenir de l’entreprise. Cela est d’autant plus vrai qu’elle a été secouée par plusieurs scandales liés justement à l’intelligence artificielle ces dernières années. En 2020, la firme de Mountain View a par exemple licencié Timnit Gebru, membre de son équipe dédiée à l’éthique en IA, après que celle-ci ait dénoncé les pratiques de son employeur de l’époque.

Deux mois plus tard, sa co-dirigeante de l’IA éthique chez Google, Margaret Mitchell, a elle aussi été licenciée pour violation du code de conduite de l’entreprise. Après ces deux limogeages, Samy Bengio, dirigeant de Google Brain, a pris la décision de démissionner. Ici, le cas de Blake Lemoine est différent, mais il n’est pas sans rappeler le passif difficile de Mountain View avec sa division IA. D’ailleurs, la firme a annoncé, en 2021, l’arrêt de plusieurs projets liés à l’intelligence artificielle au nom de l’éthique.