« Ce n’est qu’un mot marketing pour vendre des services. Je suggère le boycott du mot cloud », soutient à Siècle Digital Richard Stallman, le développeur à l’origine du système d’exploitation libre GNU. L’informaticien considère que « beaucoup de choses sont invisibles derrière le mot cloud ». C’est d’ailleurs probablement ce point qui perd les novices du secteur dans les nombreuses notions que regroupe le terme de cloud computing : Infrastructure as a Service (IaaS), Plateforme as a Service (PaaS), Software as a Service (SaaS), edge computing, data center, serveur, cloud privé, cloud public, cloud hybride, multicloud, cloud gaming… L’académie française ne s’est d’ailleurs pas encore penchée sur la définition du mot cloud. Le Larousse et Le Robert l’ont baptisé informatique en nuage. Au Québec, c’est le mot infonuagique qui est utilisé.

La part du stockage local, c’est-à-dire sur un ordinateur ou un téléphone, diminue au profit d’une externalisation, notamment par le biais de services cloud. Toutefois, l’Académie des technologies relève dans un rapport (pdf) publié en octobre 2020 que « paradoxalement, les capacités disponibles de stockage en centres de données ne représentent en 2020 que 40 % des données numériques ». Avec les répercussions de la crise sanitaire sur le travail, les organisations ont plus que jamais recouru à des outils de collaboration comme la visioconférence ou le partage de fichiers. Certaines entreprises qui stockaient leurs données sur site ont dû adopter des solutions cloud pour pouvoir consulter et traiter leurs données à distance. Grands groupes ou PME, la majorité des structures ont été contraintes d’accélérer leur transition numérique et de s’orienter vers le cloud.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

De manière simple et succincte, les services cloud regroupent plusieurs services informatiques : des applications, des plateformes et des infrastructures. Leur principale force réside dans une accessibilité sans précédent : n’importe où et n’importe quand. Le tout pour un coût abordable. Les services cloud se sont fait connaître du grand public à travers des produits comme Google Photos et iCloud. De nombreuses entreprises connues des particuliers comme Spotify, Uber, Facebook, ainsi que des services pour professionnels comme la solution 356 de Microsoft, ont développé un modèle basé sur ce qui est appelé le cloud. Pour l’utilisateur les avantages sont nombreux. Plus besoin de se soucier de transférer des données sur un stockage local, le cloud le fait avec la promesse de ne jamais perdre un octet. En ajoutant la synchronisation des données, ces services se veulent pratiques et sûrs.

Le modèle SaaS, la star des services cloud

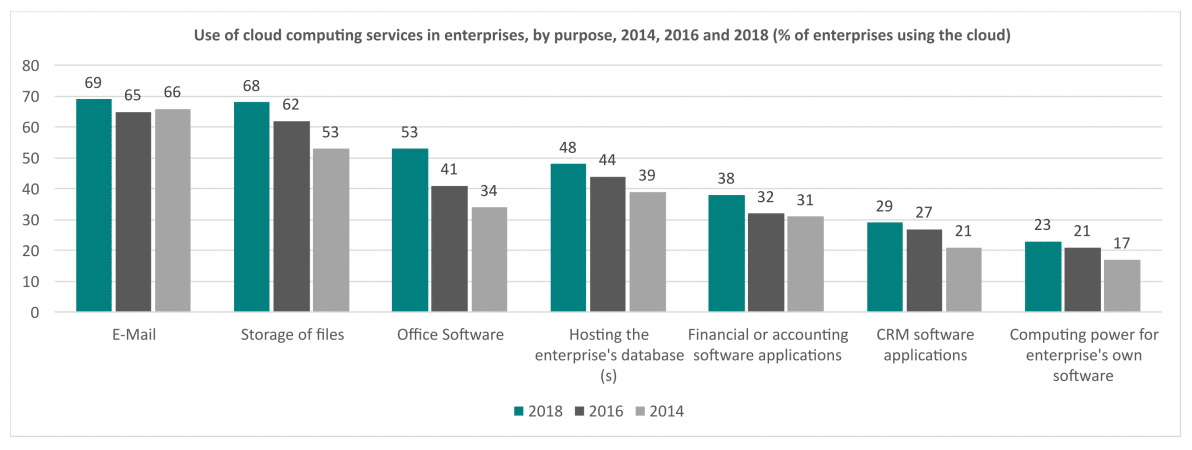

Pour la transformation numérique des entreprises, l’utilisation de services cloud facilite la mise en place de solutions informatiques en limitant les investissements financiers et techniques. À l’origine d’une stratégie cloud, différentes raisons se mêlent. La première : la flexibilité. Le cloud permet de s’affranchir de contraintes matérielles et administratives, en déléguant ces tâches à des tiers. Vient ensuite la scalabilité, qui désigne la capacité d’un service à adapter ses puissances de calculs afin de maintenir ses fonctionnalités et performances, par exemple en passant de 10 à 10 000 utilisateurs en cas de forte demande. Enfin, la performance informatique, notamment en accédant à des services complémentaires au cloud qui sont comptés dans un abonnement, offre une meilleure maîtrise des coûts. En 2018, les services de cloud computing étaient majoritairement utilisés pour les mails, le stockage de documents et les logiciels.

Répartition de l’utilisation des services de cloud computing dans les entreprises. Source : Eurostat. Crédit : Commission européenne

Du point de vue d’une PME n’ayant pas de directeur des systèmes d’information (DSI), ou d’ingénieur qualifié, déléguer la gestion de certains outils est essentiel, autant pour des raisons de sécurité que de performance. C’est le cas des serveurs qui demandent régulièrement le remplacement de certains composants, et donc des compétences techniques. Cette délégation d’une partie de la gestion des systèmes d’information prend trois formes : IaaS, PaaS et SaaS.

La délégation la plus absolue est le SaaS, qui pourrait être qualifié de solution tout en un. Un logiciel SaaS donne un accès à un programme sans nécessiter d’installation sur la machine de l’utilisateur qui accède au service via internet. De son côté, l’éditeur gère les mises à jour, la sécurité, et d’autres points techniques. « Microsoft va délivrer un service complet sans qu’il y ait un besoin pour le client de faire du technique », résume à Siècle Digital Xavier Garonnat, consultant chez Cosmo Consult. Il estime que le SaaS est la solution la plus demandée par ses clients.

À la fondation Mérieux, fini les tableaux Excel et bienvenu au 100% SaaS

Aujourd’hui, une grande majorité de solutions numériques sont en mode SaaS : Zoom, Netflix, Salesforce, Google Workspace, etc. Le SaaS figure comme la solution idéale pour connecter facilement différents systèmes informatiques. D’un côté un CRM peut être relié à outil de communication type Slack. De l’autre, le même outil peut être utilisé simultanément en France et aux États-Unis sans baisse de performances. Le SaaS a aussi pour atout de nécessiter moins de main-d’œuvre pour les entreprises utilisatrices, puisqu’une grande partie de la gestion est assurée par les éditeurs.

Depuis décembre 2020, la fondation Mérieux a abandonné les tableaux Excel pour une formule 100% SaaS comprenant le logiciel de gestion Microsoft Dynamics, la suite Office, ainsi que des logiciels d’automatisation et de business intelligence. Présente sur plusieurs continents, l’objectif de la fondation est d’apporter « le même niveau de service à tous les collaborateurs, même en Haïti », expose à Siècle Digital Clélia Lebayle cheffe du projet informatique de la fondation Mérieux.

Quelques mois après la mise en place des nouveaux outils, les résultats ressentis sont positifs. Clélia Lebayle met en avant une collaboration facilitée entre les équipes sur le terrain et le siège à Lyon, une harmonisation en gestion de projet, ainsi qu’un gain d’efficacité, notamment en évitant de saisir à deux reprises la même donnée. Afin de veiller à l’adaptabilité des logiciels face à toutes les situations, la solution va être éprouvée sur un exercice complet afin de s’assurer qu’aucun blocage technique n’entrave le bon fonctionnement des logiciels.

Étant en 100% SaaS, la fondation n’a pas besoin d’une armée de développeurs pour gérer ses nouveaux systèmes. Elle a un DSI, un chef de projet et un technicien dont le poste a été externalisé à un prestataire qui fournit le travail d’un équivalent temps plein. Toutefois, pour monter le projet, la Fondation Mérieux a largement mobilisé ses équipes. Elle a mis en place un système de “key users” : des employés qui ont contribué à l’élaboration du projet à côté de leurs tâches habituelles. Les “key users” ont participé au choix du prestataire et à l’identification des besoins afin d’élaborer le schéma directeur du projet.

« Le consommateur n’est pas là pour acheter du cloud, mais pour acheter un service »

L’IaaS et le PaaS font office de niveaux intermédiaires où le client « pilote le curseur entre lui et le service », image Xavier Garonnat. Dans un modèle IaaS des châssis de serveurs de disques durs sont vendus. Dans le PaaS, en plus de louer des serveurs, le client utilise des logiciels d’infrastructure appelés middleware, comme des bases de données ou des systèmes d’exploitation. En PaaS, la maintenance est assurée par le prestataire de services cloud. Du point de vue de l’implication du client dans son infrastructure, le PaaS rejoint le SaaS avec moins de responsabilités techniques.

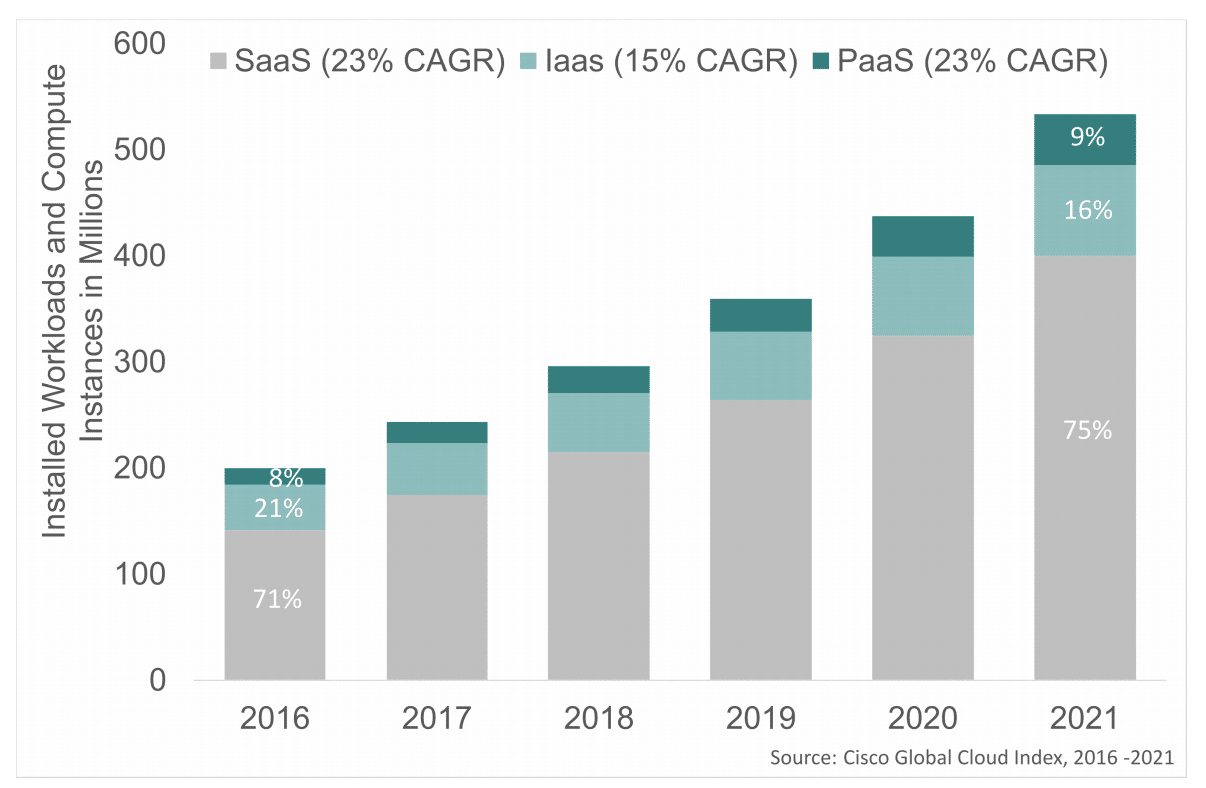

L’IaaS est donc le niveau le plus autonomisant techniquement et fait référence à du matériel informatique. C’est en partie ce qui explique que les perspectives de croissance de l’IaaS sont moins fortes que le SaaS et le PaaS (voir graphique ci-dessous). L’entreprise cliente installe des applications et logiciels, et les données y transitant sont traitées sur des serveurs loués au prestataire cloud. L’achat concerne uniquement un espace de stockage et l’utilisateur s’occupe de la partie technique de ses applications. Néanmoins, le client final peut choisir d’être autonome ou d’infogérer une partie de son infrastructure à un, ou plusieurs tiers. L’indépendance n’est donc pas une fatalité et peut être déléguée si l’entreprise utilisatrice le souhaite.

Évolution de l’utilisation des modèles SaaS, IaaS, PaaS. Source : Cisco. Crédit : Commission européenne

La démocratisation de ces modèles entraîne la normalisation de l’externalisation du stockage. Néanmoins, cela n’incarne pas la principale fonctionnalité recherchée par le client. Afin de faire tourner des logiciels à distance, les data centers, en plus de leur rôle de stockage, fournissent de la puissance de calcul pour faire tourner les logiciels. « Le consommateur n’est pas là pour acheter du cloud, mais pour acheter un service […] Quand on vend une solution, on vend aussi du cloud », explique Xavier Garonnat à propos de Microsoft Dynamics, une suite de logiciels s’appuyant sur le cloud.

La valeur de ces outils ne réside donc pas dans l’externalisation du stockage, mais dans l’accès à des services. Par ailleurs, la sécurité est gérée par le prestataire et les données sont davantage protégées des rançongiciels. De fait, les hyperscalers, nom donné aux leaders des services cloud comme les GAFAM et les BATX, ont plus de ressources à allouer à la sécurité qu’une PME ou même un groupe non spécialisé dans l’informatique.

Un ou des prestataires ? Les entreprises ont le choix

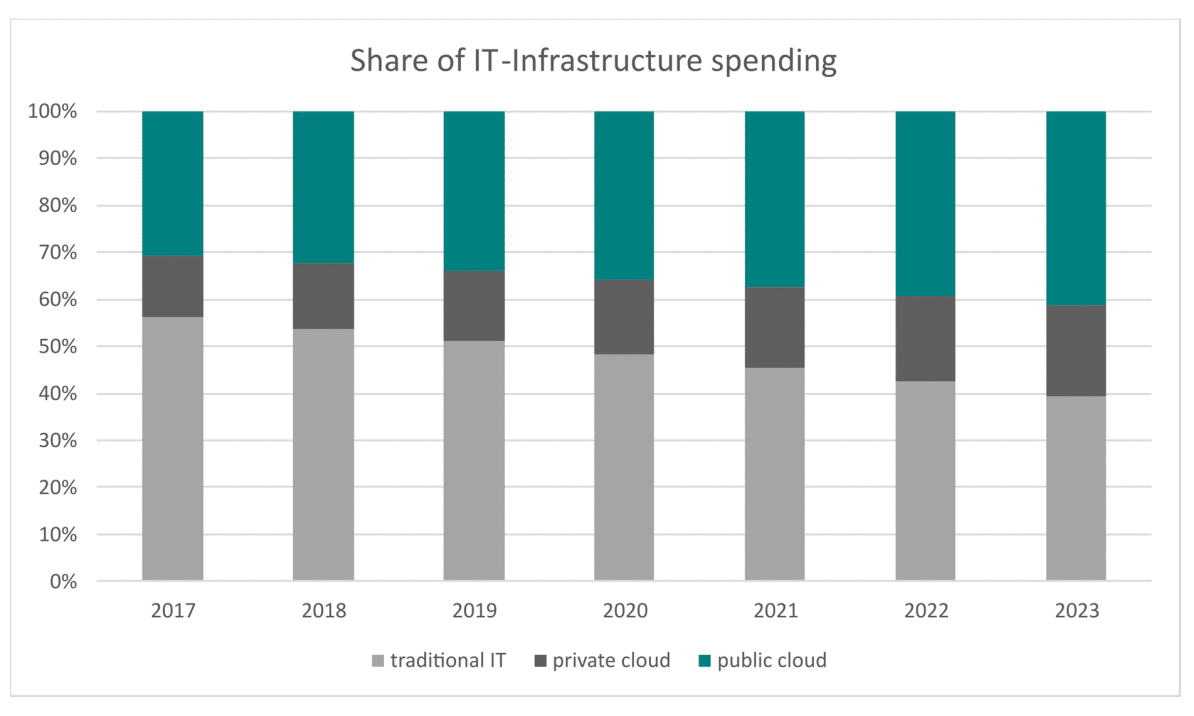

Il existe quatre types de configurations cloud : cloud public, privé, hybride et multicloud. Aujourd’hui, les offres de cloud public prennent le pas sur les offres privées.

Cloud public

En cloud public, le fournisseur propose différentes ressources accessibles uniquement par internet. Cette architecture est dite multi-tenant, c’est-à-dire que l’espace stockage est partagé entre plusieurs utilisateurs, qui ne savent pas où sont stockées leurs données. En comparaison avec une solution privée, son avantage réside dans la possibilité d’augmenter la capacité de stockage. Aussi, le fournisseur cloud est chargé de la maintenance des serveurs. Néanmoins, la contrepartie est que l’entreprise n’est pas maître de son paramétrage, et, par exemple, elle n’a pas la possibilité de choisir la puissance de calcul. Cette architecture de cloud concerne majoritairement le mode SaaS, et donc des services comme Gmail ou la suite bureautique Office 365. Le leader des solutions de cloud public est Amazon Web Services (AWS).

Cloud privé

Dans une configuration en cloud privé, deux possibilités se présentent au client. Soit le prestataire de services assure le stockage, soit ce dernier est effectué sur les serveurs de l’entreprise. Dans les deux cas, un client unique possède un ensemble de ressources qu’il organise et exploite selon son bon vouloir dans son propre espace. L’entreprise paramètre elle-même la sécurité de son infrastructure, un détail d’importance. En effet, ce format est privilégié par des structures ayant des contraintes de sécurité élevées comme le secteur bancaire ou celui de la défense. Dans la majorité des cas, l’entreprise a la certitude que son espace de stockage est situé dans telle région. Néanmoins, contrairement au cloud public, le cloud privé laisse à la charge de l’utilisateur l’entretien des serveurs.

Évolution de la répartition de solutions de cloud privé, public et traditionnel (mainframe). Source : IDC. Crédit : Commission européenne

Cloud hybride

En fonction des besoins, il est possible, et plutôt commun, d’exploiter à la fois du cloud public et du cloud privé. À ce moment-là, la solution est qualifiée de cloud hybride. Dans cette configuration, les solutions privées et publiques sont achetées au même fournisseur. Dans une architecture hybride, les clouds sont reliés entre eux grâce à des fonctions d’intégration et d’orchestration. « 100 % des entreprises ont de l’hybride dans la réalité », affirme à Siècle Digital Nosing Doeuk, le directeur associé en charge de l’offre Innovation et Technologies du cabinet de conseil mc2i. Dans la pratique, une entreprise fonctionne en hybride si elle utilise d’un côté la suite Google, donc un cloud public, et d’un autre, un espace privé, également acheté chez Google, pour stocker certaines données, comme le développement d’un nouveau produit ou des données économiques sensibles.

Multicloud, réversibilité et interopérabilité : « Ça se fait théoriquement facilement »

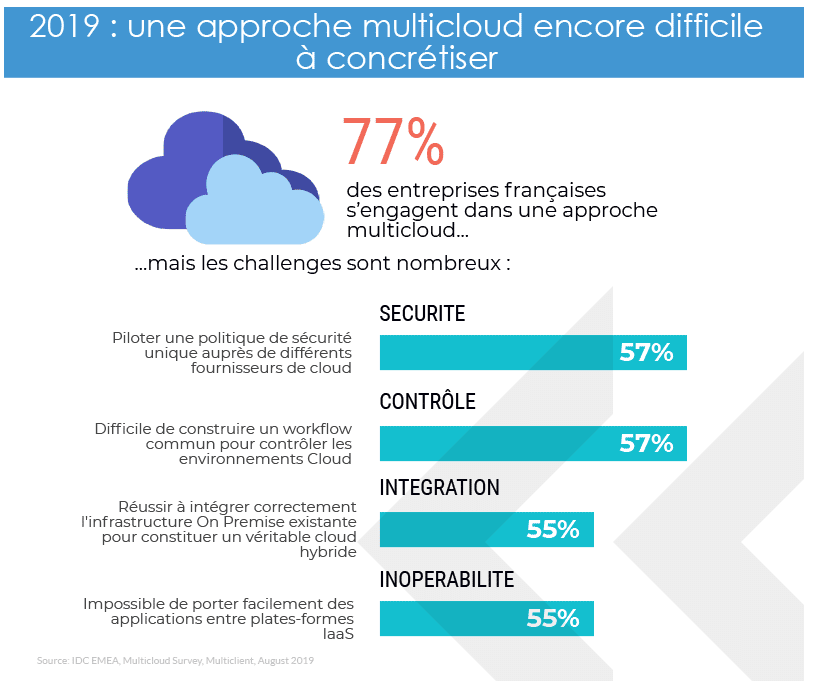

Le multicloud désigne l’utilisation de solutions publiques et privées achetées chez des prestataires différents. C’est le cas d’une entreprise qui utilise un serveur de stockage chez AWS, loue en parallèle une base de données chez Google Cloud et qui effectue des sauvegardes chez OVH. En 2020, quatre entreprises sur cinq ont opté pour du multicloud. En croisant les services de plusieurs fournisseurs, le multicloud soulève des questions sur la réversibilité et l’interopérabilité des données. C’est-à-dire, dans le premier cas, la possibilité de récupérer ses données et, dans le deuxième, la capacité de plusieurs systèmes informatiques à fonctionner entre eux. Selon Nosing Doeuk, « ça se fait théoriquement facilement ». Le directeur associé compare cette situation avec celle d’un changement de contrat d’assurance. En France, il est possible de changer d’assureur, néanmoins, quand cela se passe il faut relire toutes les petites lignes pour s’assurer de conserver les mêmes garanties.

Une configuration multicloud permet de choisir un data center en accord avec les réglementations auxquelles est soumise l’entreprise, comme le RGPD. Aussi, les avantages résident dans la rapidité des transferts de données, notamment en pouvant choisir un data center proche de l’entreprise pour les données nécessitant un accès rapide. Le gain est de quelques millisecondes. L’adaptabilité du multicloud permet de faire des économies financières. Le client choisit des services cloud en fonction de ses besoins, notamment de sécurité ou de coût, qui selon le niveau choisi, ont des variations de prix significatives. Enfin, en optant pour une solution multicloud les données sont confiées à différents prestataires ce qui peut être gage de protection. En effet, pour les hackers, plus de prestataires signifie plus de nœuds et de codes à craquer.

En multicloud il faut être particulièrement vigilant aux degrés de sécurité imposés par les données traitées. En effet, si une donnée sensible est transférée vers une autre application qui elle-même est rattachée à un cloud moins cher, et donc possiblement avec des standards de sécurité plus faibles, il y peut y avoir une rupture dans la sécurisation de la donnée. Aussi, la donnée, en changeant de serveur, peut passer sous la législation d’un autre pays.

Défis à relever dans une architecture en multicloud. Source : IDC

Mainframe ne veut pas dire mainstream

« Le cloud c’est très séduisant, mais je dois aussi prévoir que mon service fonctionne tout le temps », explique à Siècle Digital Frédéric Van Camp, le DSI du service départemental d’incendie et de secours du Pas-de-Calais (SDIS 62). Disponibles plus de 99 % du temps, les services cloud ont quelques brèves interruptions à l’année. AWS, et ses pairs, sont soumis à un taux de disponibilité contractuelle, c’est-à-dire un temps minimum sur lequel l’entreprise s’engage à mettre à disposition son service. Aujourd’hui, il s’élève à 99,9x%, la différence se faisant sur les centièmes. Ce qui est incompatible avec les activités des sapeurs pompiers, dont les services doivent être accessibles 24 heures sur 24, 7 jours sur 7, et 365 jours par an.

Le SDIS enregistre tous les appels reçus, notamment pour l’éventualité où une adresse serait mal notée au moment de l’appel, ou pour justifier leur bonne intervention dans le cas d’un recours pour non-assistance à personne en danger. Pour une intervention, les pompiers peuvent recevoir jusqu’à six appels : témoins, proches de la victime, SAMU, etc. Cela oblige les SDIS à avoir une stratégie de stockage fiable… et à coût pas trop élevé, service public oblige. Aussi, si un service cloud est touché par un rançongiciel, couper internet suspend le service et l’accès aux données. Dans l’activité de sapeurs-pompiers cela n’est pas permis, et mettrait des vies en péril. Dès lors, souscrire à une formule cloud n’incarne pas une bonne solution pour les SDIS et le mainframe, c’est-à-dire un serveur en dur, répond à cette problématique d’accessibilité et de réactivité.

« La donnée a un coût, une pondération »

Néanmoins, avoir ses propres serveurs demande la mise en place de procédures de sécurité et de protection des données. Pour cela, le DSI du SDIS 62 a fait appel à StorageCraft, une entreprise américaine spécialisée dans la sauvegarde pour serveurs informatiques et postes de travail, et le stockage secondaire en mode objet. L’un des atouts principaux de sa solution de stockage – OneXafe – est que les snapshots des données sont immuables. C’est-à-dire que dans le cas d’un rançongiciel, les données sont totalement protégées : elles ne peuvent être ni encryptées, ni modifiées, ni effacées. Les données hébergées sur la baie OneXafe sont découpées en objet, et celle-ci crée 3 copies de chaque objet, afin d’augmenter la sécurité. Dès qu’il y a un changement, un nouvel objet est créé, tout en conservant l’ancien. Les pompiers pourront donc toujours avoir accès à leurs données.

« La donnée a un coût, une pondération. Et en fonction, on va se tourner vers telle ou telle baie de stockage », explique Frédéric Van Camp. Le DSI du SDIS 62 différencie les données chaudes – utilisées quotidiennement – et les données froides – utilisées ponctuellement. Sur cette base de différenciation, toutes les données du SDIS 62 ne sont pas chiffrées. Par exemple, l’enregistrement des appels ne l’est pas, car le SDIS 62 a besoin de les réécouter. S’ils étaient chiffrés, pour pouvoir les écouter rapidement, il faudrait les déchiffrer et les renchiffrer, ce qui demande plus d’investissement tant technique que financier. Le chiffrement pose une autre question : « Si c’est chiffré, est-ce que dans 15 ans j’ai les logiciels pour déchiffrer ? », interroge Frédéric Van Camp qui doit conserver les données du SDIS pendant 15 ans. Aussi, chiffrer les données n’est pas gage d’une sécurité à 100%. Pour Maxime Guedj, ingénieur, entrepreneur et co-auteur de Déclic, Comment profiter du numérique sans tomber dans le piège des géants du web, la pleine sécurité n’existe pas : « C’est sécurisé jusqu’à ce qu’il y ait une technologie plus forte pour déchiffrer ça ».

Au-delà du cloud : se trouvent des centres de données et des câbles

« Le mot cloud oublie les serveurs, les data centers, pour mettre en avant le pratique et le magique […] Ça reste d’autres serveurs, d’autres machines, qui appartiennent à une structure, dans laquelle on fait confiance pour stocker nos données », rappelle Maxime Guedj à Siècle Digital. En effet, il est important de garder à l’esprit que pour traiter, stocker et entreposer des données, des data centers fleurissent à travers le monde. Ces centres de données nécessitent de nombreux éléments interconnectés par des câbles et des racks : serveurs, sous-systèmes de stockage, commutateurs de réseaux, routeurs, firewalls, systèmes de ventilation et de refroidissement… La conception des data centers prend des formes multiples. Si des grands groupes comme Facebook ont recours à d’immenses entrepôts, tous les centres de données ne sont pas nécessairement géants. C’est le cas des serveurs présents sur le site d’une entreprise non spécialisée dans l’informatique.

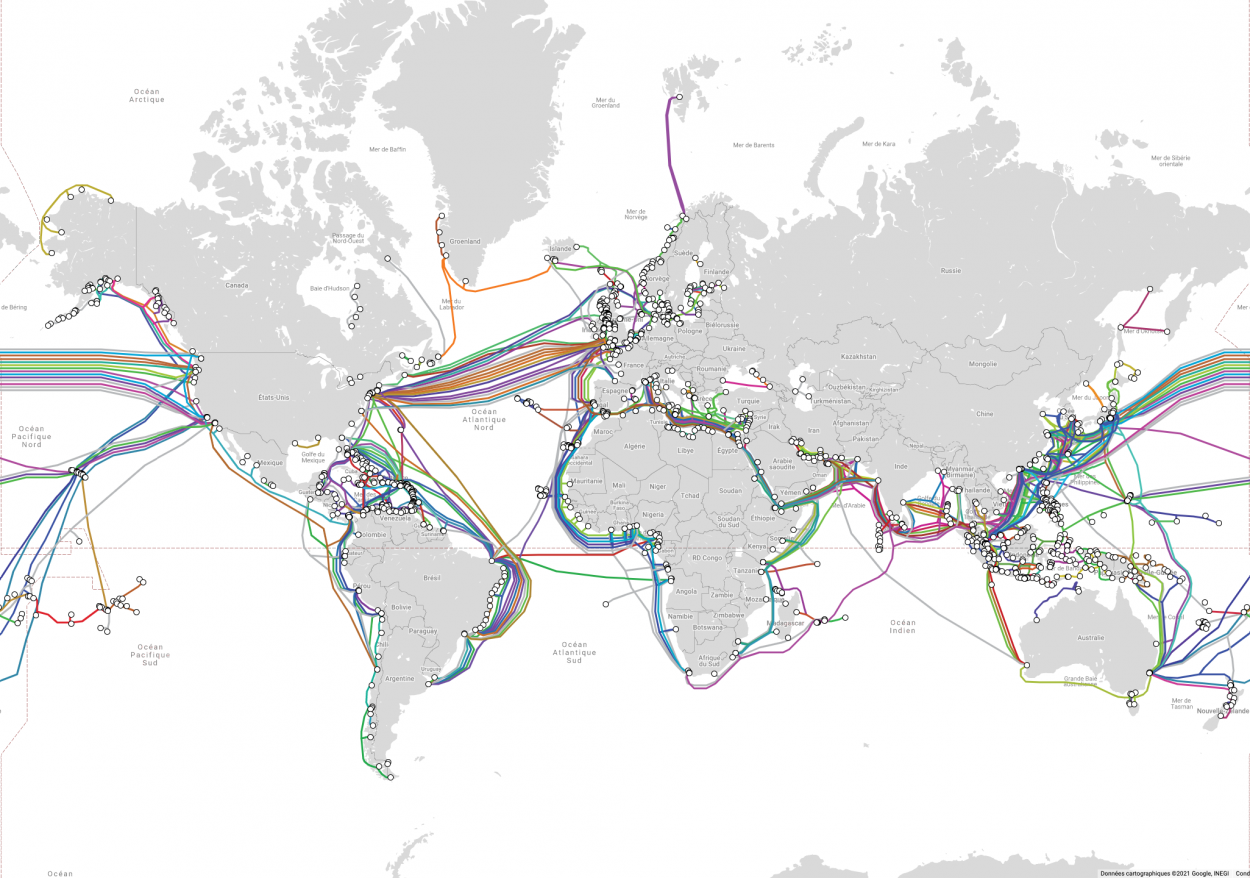

Pour fonctionner et se connecter, l’ensemble de ces éléments nécessitent de l’électricité. Il faut donc un système de distribution d’énergie, un commutateur électrique, des réserves d’énergie et des générateurs. Mais aussi, et surtout, une bande passante pour acheminer les données. Les réseaux internet sont constitués de câbles et des fibres optiques. Pour le fonctionnement des services cloud, les infrastructures télécoms sont donc essentielles. Selon les informations de Google, en 2020, 98% du trafic Internet international passait par des câbles sous-marins. Ce chiffre varie selon les sources. Le Figaro note que plus de 90% des liaisons internet sont assurées par des câbles sous-marins.

Répartition des câbles sous-marins dans le monde. Source : submarinecablemap.com.

La propriété de ces câbles internet est hautement stratégique. Dès qu’une donnée transite sur un câble, elle est consultable par son propriétaire. Cela pose bien évidemment des questions de souveraineté et d’espionnage. Ainsi, le Brésil et l’Europe ont construit un câble entre le vieux continent et l’Amérique latine. Le projet a signé sa réussite en janvier 2021, en reliant la ville portugaise de Sines avec la ville brésilienne de Fortaleza. Au-delà des acteurs institutionnels, des groupes privés se lancent dans la course aux câbles. En juillet 2020, Google a inauguré son quatrième câble. Cette diversification des acteurs investissant dans les réseaux inquiète d’ailleurs les États-Unis qui perdent leur mainmise sur le secteur. En 2018, la NSA estimait que 80% des données mondiales passaient par les États-Unis.

Le cloud n’est qu’à ses débuts

Stratégiques, ces réseaux de câbles nécessitent des dispositions particulières afin d’assurer la pérennité des données. L’entreprise BSO Network propose des solutions d’infrastructures réseaux pour applications critiques, notamment pour relier les places boursières entre elles. Pour connecter les bourses de New York et de Londres, l’entreprise va mettre en place, a minima, deux circuits de câbles ou de fibres optiques par lesquels vont transiter les données. Si une “route” a un problème, l’autre prend le relais. Dans certains cas plus rares, en plus d’utiliser deux routes, les données sont également doublées. L’objectif : apporter une stabilité optimale aux réseaux.

Au-delà de connecter les places boursières entre elles, les services de BSO s’adressent à ceux qui interconnectent des réseaux. C’est le cas des plateformes marchandes, comme Rakuten, un client de BSO. Encore une fois, il n’y a pas de sécurité parfaite. Certains problèmes restent difficilement anticipables comme les intempéries météorologiques. À Houston, une tempête hivernale a déjà endommagé des réseaux de câbles. Un autre des enjeux de l’activité de BSO est de cartographier l’ensemble des câbles par lesquels transitent les données afin de proposer les meilleurs chemins. Souvent les risques sont d’ordre géopolitique, par exemple pour se prémunir d’éventuels regards indiscrets. Par ailleurs, beaucoup de câbles internet ont été construits dans les années 60 et sont aujourd’hui saturés. De nouveaux investissements sont donc attendus. Ces câbles sont installés en mer au fond de l’eau, ou sous terre, le long des autoroutes ou dans les égouts. Pour certains citadins, ils sont visibles dans les métros.

Le développement des services cloud va être boosté par le développement de la 5G et de l’edge computing, qui, en simplifiant, repose sur le déploiement d’une multitude de serveurs placés en périphérie du réseau. Les machines étant plus proches des utilisateurs, la rapidité des transferts de données augmente. L’edge computing facilite ainsi le développement de l’Internet des Objets (IoT). À ce stade de l’article, il n’y a plus de mystère : derrière les services cloud, il y a des données. Des données qui vont faciliter les technologies dites d’intelligence artificielle (IA). À l’image de ce qu’est le pétrole pour l’essence, les données sont la matière première des programmes d’IA. Pour cause, leurs algorithmes se nourrissent de données. De fait, l’acteur qui développera le plus son IA sera celui qui aura le plus de données. Les programmes dits d’IA sont déjà omniprésents et l’IoT accentue cette tendance. Utiliser des services cloud, c’est faciliter leur développement.

En 1973, dans son livre La Convivialité, Ivan Illich avertissait sur l’erreur faite par l’Homme dans son rapport à l’outil : « La prise de l’homme sur l’outil s’est transformée en prise de l’outil sur l’homme. […] Durant un siècle, l’humanité s’est livrée à une expérience fondée sur l’hypothèse suivante : l’outil peut remplacer l’esclave. Or il est manifeste qu’employé à de tels desseins, c’est l’outil qui de l’homme fait son esclave ». Avec des IA dopées aux données des services cloud, ce que dénonçait Ivan Illich se poursuit sous une nouvelle forme qui ne touche plus seulement l’industrie, mais la majorité des métiers existants : avocats, médecins, traducteurs, etc. Une réflexion, notamment politique, doit être initiée.