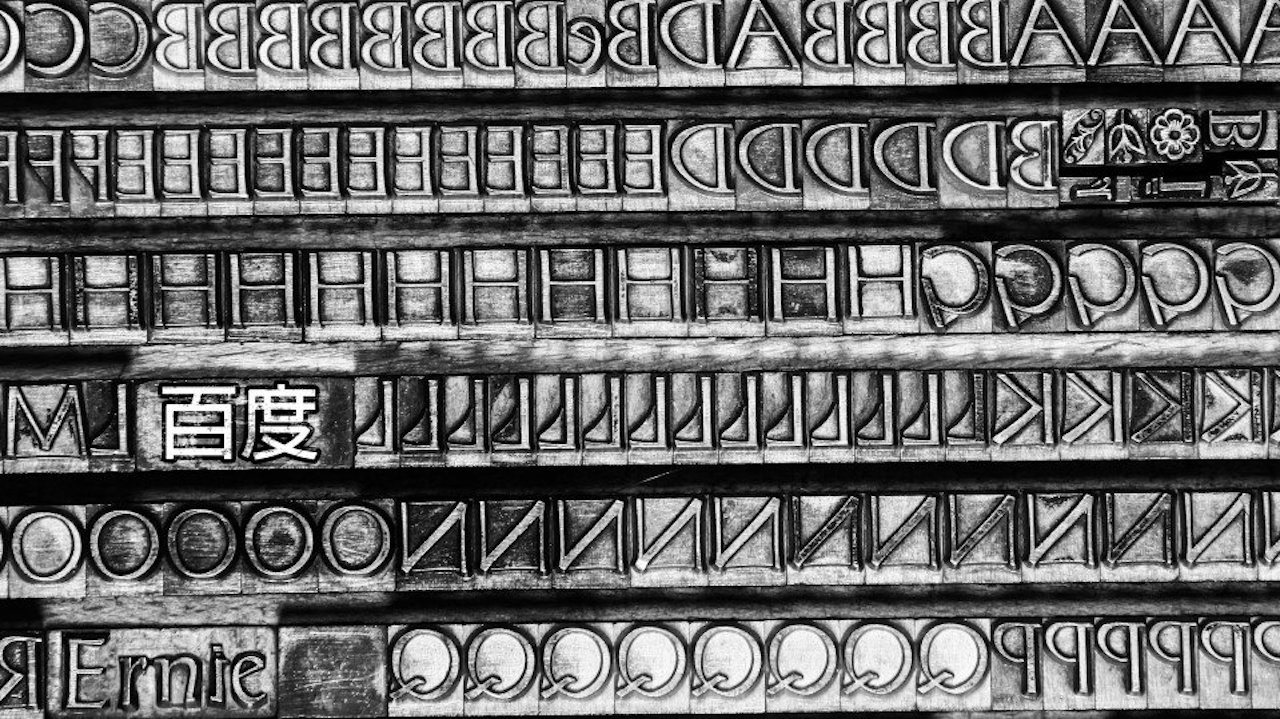

Si l’intelligence artificielle est douée par analyser des mots-clés au sein d’une phrase, elle a encore du mal à assimiler parfaitement le langage naturel des humains. À travers le monde, les géants technologiques se livrent une bataille pour créer le modèle le plus performant dans ce domaine. Baidu présente ERNIE pour « Enhanced Representation through kNowledge IntEgration », le modèle le plus performant du marché.

ERNIE bat tous les records

Les géants technologiques confrontent leur modèle au test GLUE, qui est une référence largement acceptée de tous les acteurs du marché, pour déterminer dans quelle mesure un système d’intelligence artificielle comprend le langage humain. Ce test permet aux modèles d’IA d’obtenir un score sur 100. Un humain obtient en moyenne un score de 87/100. Grâce à son nouveau modèle de compréhension du langage naturel, Baidu a obtenu 90/100. La particularité de ce modèle est qu’il est capable de comprendre l’anglais comme le chinois.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

En octobre, Google présentait aussi un nouveau modèle baptisé BERT : une mise à jour majeure de l’algorithme qui devait permettre au moteur de recherche d’améliorer sa compréhension du langage naturel. Google BERT pour “Bidirectional Encoder Representations from Transformers” a pour mission de mieux comprendre les relations entre les mots au sein d’une phrase entière. Les cartes sont totalement rebattues : Google veut comprendre le sens précis des questions de ses utilisateurs et non plus seulement les mots-clés. D’après Google, cette mise à jour est : « la plus grande amélioration du Search depuis 5 ans, et l’un des plus grands bons en avant de l’histoire du Search ». Malheureusement pour Google, BERT n’est pas aussi puissant qu’ERNIE.

Une technique d’apprentissage novatrice

Pour améliorer un modèle de compréhension du langage naturel, les géants technologiques travaillent sur le « masquage des mots ». Habituellement, un modèle d’apprentissage cache au hasard 15% des mots et tente de les prédire à partir des autres mots qui composent la phrase. Cela permet de faire des prédictions très précises et surtout de rendre le modèle autonome. Prenons un exemple : dans la phrase suivante : « ce matin, Gustave est allé au ___ pour acheter du lait ». Le début et la fin de la phrase donnent deux des indices sur le mot manquant.

Oui mais voilà, Baidu a été confronté à un problème de taille : la construction d’une phrase en chinois n’est pas la même qu’avec l’anglais. En effet, en anglais un mot sert d’unité sémantique, ce qui signifie que lorsque le mot manquant est retiré de son contexte, il aura toujours un sens. On ne peut pas en dire autant des caractères chinois. Bien que certains caractères aient une signification précise, comme le feu (火, huŏ), l’eau (水, shuĭ) ou le bois (木, mù), la plupart n’en ont pas. Une fois séparés, les caractères chinois n’ont pas la même signification.

Pour palier cela, les chercheurs ont formé ERNIE sur une nouvelle version du masquage qui cache des groupes de caractères plutôt que des caractères uniques. Finalement, ils se sont rendus compte que cette approche fonctionne mieux pour l’anglais aussi. C’est en partie pour cette raison qu’ERNIE détrône les modèles de Google et de Microsoft.