Facebook a officiellement lancé son concours international contre les deepfakes le 11 décembre. L’occasion pour IEEE Spectrum, magazine professionnel de « la plus grande organisation professionnelle mondiale consacrée à l’ingénierie et aux sciences appliquées » de revenir sur l’ensemble des initiatives américaines menées pour lutter contre les deepfakes.

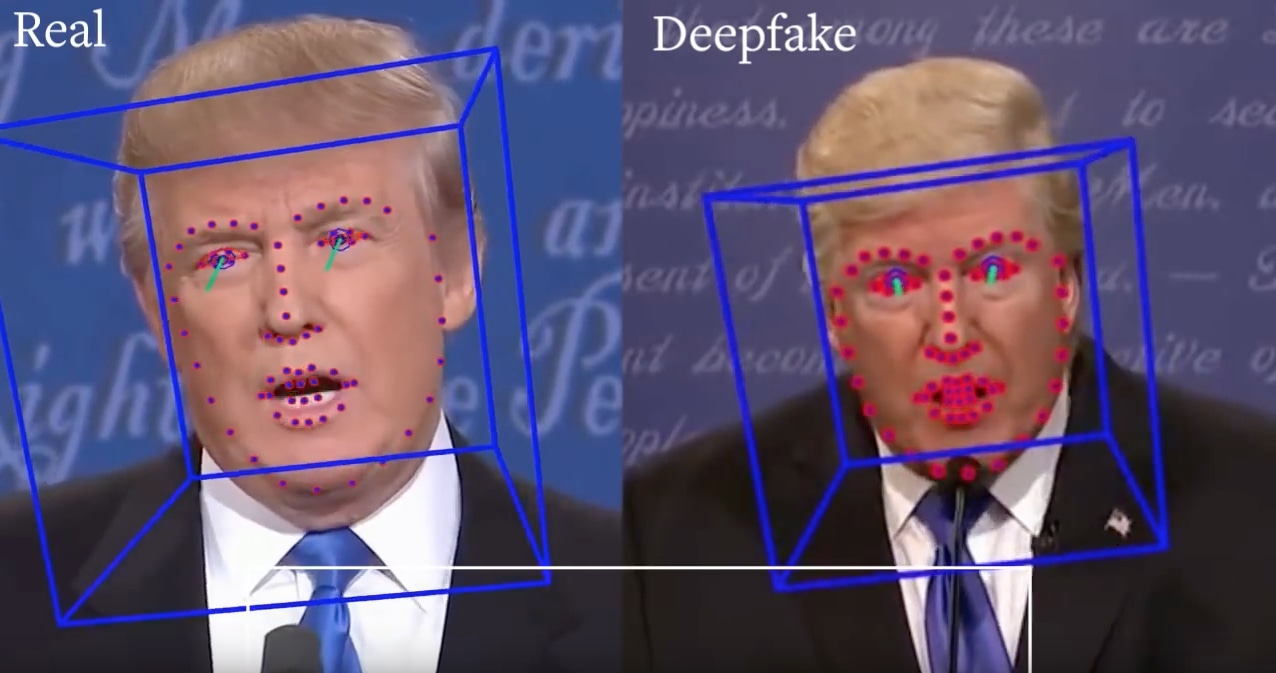

La pratique a commencé à faire parler d’elle en 2017 sur Reddit. Basé sur l’intelligence artificielle, le deepfake consiste à modifier une vidéo de façon à permuter le visage de la personne à l’écran par celle d’une personne tierce. Le deepfake peut en soi être un simple divertissement, Snapchat en a fait une fonctionnalité, une application chinoise, Zao, connait un énorme succès depuis septembre en Chine, mais il peut être détourné de façon inquiétante.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

C’est surtout pour ses dérives potentielles et réelles que le deeepfake fait parler de lui aujourd’hui. On craint à travers le monde l’émergence de fake news particulièrement évoluées, et à même de pirater la démocratie. Déjà des cas de revenge porn et le détournement d’images de célébrité ont fait parler d’eux.

Les Etats-Unis ont déjà légiféré pour interdire les deepfakes pornographiques, la Californie y a ajouté l’aspect politique, et la Chine considère désormais comme un crime la diffusion d’une deepfake. En France un député a interpelé le gouvernement sur cette épineuse question mi-octobre. Le secrétaire d’État au numérique a assuré que l’arsenal législatif français était suffisant pour encadrer cette pratique.

Ces cadres légaux sont plus que bienvenus, mais sans doute bien insuffisants pour limiter de façon suffisamment précoce les dégâts d’une manipulation. Heureusement, pour l’heure, les deepfakes capables de tromper l’œil humain sont techniquement difficiles d’accès, mais comme le montre l’application Zao cela pourrait changer très rapidement.

En prévention, entreprises des GAFA, fondation spécialiste en IA et une agence gouvernementale américaine cherchent ensemble ou isolément des moyens d’identifier automatiquement et immédiatement un deepfake.

Facebook organise un concours pour trouver le meilleur outil de détection possible

Facebook l’a annoncé en septembre, le Deepfake Dectection Challenge vient d’être lancé le 11 décembre en partenariat avec Microsoft, Amazon et 8 universités. Les chercheurs inscrits, originaires du monde entier, auront jusqu’à mars 2020 pour proposer leur outil de détection automatique. Le réseau social compte investir 10 millions de dollars répartis entre des subventions et des récompenses pour les vainqueurs.

Concrètement, Facebook a recruté des acteurs placés dans différents environnements pour créer un ensemble de deepfakes pour constituer des données à étudier pour les chercheurs. Le français Jerome Pesenti, Vice-président de Facebook IA, a déclaré offrir « plus de 100 000 vidéos créées spécialement pour faciliter la recherche sur les deepfakes. Les participants utiliseront l’ensemble de données pour créer des modèles nouveaux et améliorés pour détecter les médias manipulés, et les résultats seront notés pour leur efficacité ».

Pour créer ces deepfakes Cristian Canton Ferrer, l’organisateur du concours, a expliqué utiliser des techniques en open source courantes sans préciser lesquelles, « Dans la vraie vie, vous ne pourrez pas demander à des personnes malveillantes « Pouvez-vous me dire quelle méthode vous avez utilisée pour faire cette deepfake ? » ». Selon lui il s’agit d’anticiper ce qu’il se passera dans un avenir proche, « c’est une approche du chat et de la souris ».

Jerome Pesenti vante volontiers le choix fait par Facebook d’organiser un tel concours pour lutter contre le phénomène, « Je suis confiant, […] cette approche ouverte de la recherche nous aidera à créer de nouveaux outils pour empêcher les gens d’utiliser l’IA pour manipuler des vidéos dans le but de tromper les autres ».

Chez Google aussi on est préoccupé par les deepfakes

Au sein de la firme de Mountain View, c’est Jigsaw, une branche d’Alphabet, la maison mère de Google, qui se charge des deepfakes. Cette unité est spécialisée dans la recherche de réponses technologiques à des problèmes mondiaux. Andrew Gully, directeur de la recherche technique, estime que la falsification des médias par la technologie représente une réelle menace sociétale.

Jigsaw s’est associé avec sa société sœur Google AI pour élaborer une base de données de deepfakes qui alimente l’ensemble FaceForensics, hébergé par l’Université technique de Munich. Dans la même logique que Facebook, mieux connaître les deepfakes dans leurs pluralités permet de mieux les détecter.

Gully prévient toutefois que la détection ne fait pas tout. Particulièrement sensibilisé aux conséquences politiques de cette pratique il rappelle que « Nous savons déjà à quel point il est difficile de convaincre les gens face à leurs propres préjugés. Détecter une fausse vidéo est déjà assez difficile, mais c’est facile comparé à la difficulté de convaincre les gens de choses qu’ils ne veulent pas croire ».

Un plug-in anti-deepfake intégré à son navigateur dès 2020 ?

C’est la promesse de la Fondation AI. Son président et directeur de la technologie Rob Meadows affirme qu’au début de l’année prochaine un plug-in, Reality defender, « deviendra le gardien IA personnelle des utilisateurs ». Également décliné sous la forme d’une application pour mobile, Reality Defender avertira l’utilisateur dès qu’une image ou vidéo modifiée apparaîtra à l’écran.

Quid des publicités sur-photoshopées ou des vidéos avec effets spéciaux ? Rob Meadows et ses équipes sont bien conscients de cette difficulté. Aussi Reality defender laissera à chacun la possibilité de régler la sensibilité de l’outil.

Le président de la Fondation AI espère que cette technologie sera rapidement intégrée directement à Facebook, YouTube, Twitter… Il mise justement sur la présence de Biz Stone, co-fondateur du réseau social de microblogging, dans le conseil d’administration de la fondation pour parvenir à cet objectif. L’application/plug-in a une version bêta actuellement en test. Rendez-vous en 2020 pour constater ou non son efficacité.

Le gouvernement américain n’est pas en reste

Aux États-Unis c’est l’agence du département de la défense DARPA, pour Defense Advanced Research Projects Agency, qui est en charge du dossier deepfake. Plus précisément c’est au sein du programme Media Forensics, mis en place avant l’apparition du mot deepfake, en 2016.

Matt Turek, à la tête du programme, insiste sur trois points pour détecter au mieux les trucages « l’intégrité numérique, l’intégrité physique ou l’intégrité sémantique ». Le numérique est basé sur les motifs des pixels potentiellement incohérents d’une image, le physique sur la luminosité, les ombres, etc, la sémantique par le contexte : la cohérence de la météo avec le lieu et l’horaire affichés par l’image.

Les équipes de Turek ont déjà créé un prototype de portail, destiné aux autorités publiques américaines. Ce dernier est censé détecter les manipulations des images. Lors du téléchargement d’un média sur le portail ce ne sont pas moins de 20 détecteurs, chacun avec une approche différente, qui se met en branle.

La prochaine étape sera pour mi-2020, un nouveau programme sera mis en place, Semantic Forensics. Il devra élargir le champ de recherche. Le but sera de détecter une manipulation sur tout type de support. L’autre piste sur laquelle compte se pencher le programme est un détecteur capable de jauger seul la gravité de la manipulation, « Si vous manipulez une photo de vacances en y ajoutant un ballon de plage, cela n’a vraiment pas d’importance « , dit Turek. « Mais si vous manipulez une image à propos d’une manifestation et ajoutez un objet comme un drapeau, cela pourrait changer la compréhension des gens, de qui était impliqué« .

Pour le moment sur le volet politique les deepfakes n’ont pas encore eu les conséquences dramatiques redoutées par beaucoup. Il n’est pas dit que l’accessibilité de ce procédé de manipulation soit une réalité pour les élections américaines de 2020.

La crainte de dérives semble toutefois largement justifiée comme le montre la pornographie et le cas de Scarlett Johansson déjà victime d’un deepfake. Heureusement Pornhub et Twitter ont déjà interdit les contenus pornographiques générés par IA, encore faut-il les détecter.

Il va de soi pour tous que la lutte contre les manipulations permises par la technologie des deepfakes est l’un des enjeux technologiques et sociétaux de demain. Il n’est pas plus mal que des chercheurs et organisations décident de s’y atteler sérieusement dès maintenant.