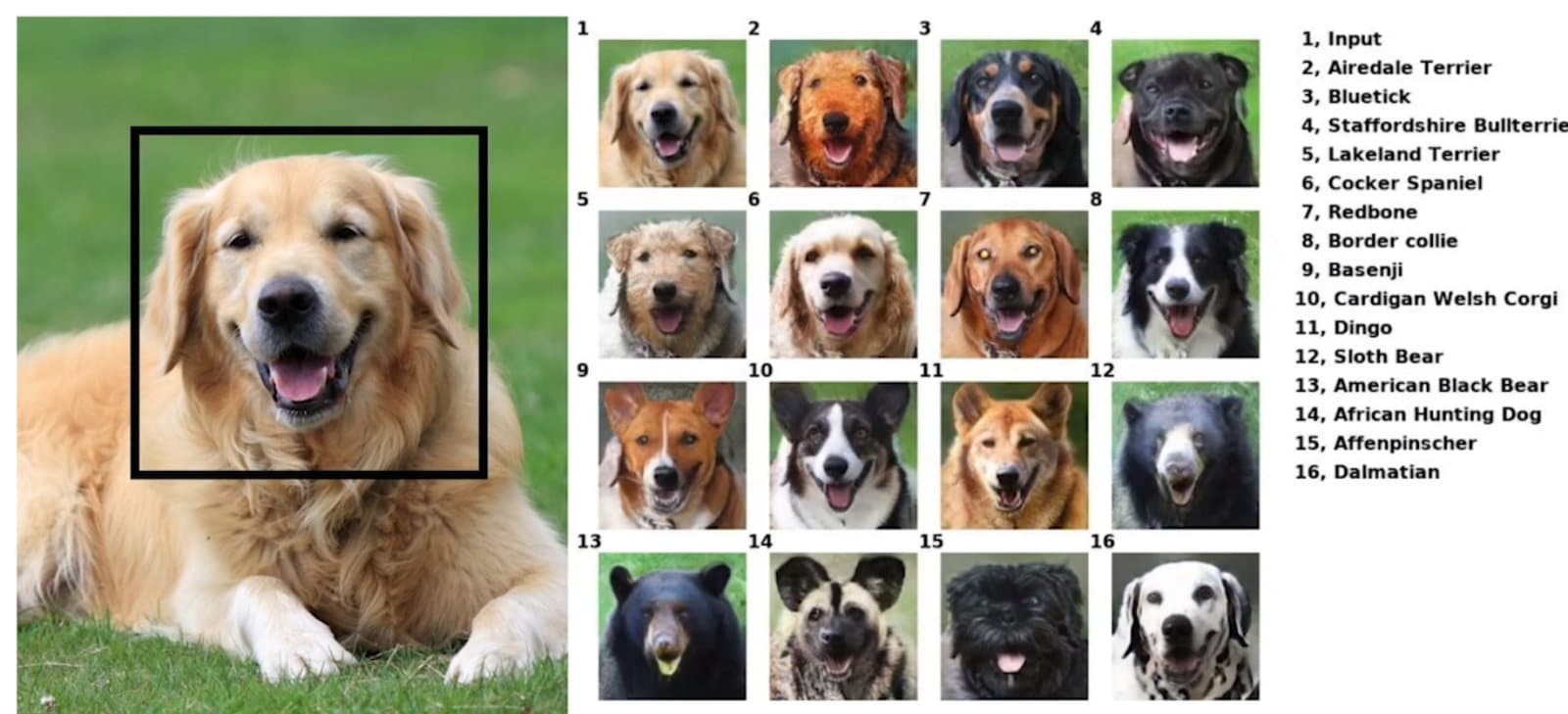

GANimal. C’est le nom d’une nouvelle IA destinée au traitement photo et développée par NVIDIA. Son objectif ? Capturer le « sourire », ou à défaut l’expression, de votre animal de compagnie et la transférer sur une large variété d’espèces différentes. Sa concrétisation est toutefois la preuve par l’exemple que l’IA et le Machine Learning ont encore du chemin à parcourir avant de retoucher nos photos de manière entièrement convaincante. Et pour cause, le résultat obtenu avec l’outil mis au point par NVIDIA s’avère assez aléatoire, comme l’illustrent les visuels dévoilés par le groupe lui-même.

Une IA qui en est à ses débuts

Sur la démonstration de NVIDIA, l’expression guillerette d’un labrador est ainsi isolée par l’outil (après une intervention de l’utilisateur), puis répliquée sur différents animaux : d’autres races de chiens, mais aussi des ours, une hyène ou encore des félins.

Le résultat final, lui, est variable, un peu à la manière de ce que d’autres outils similaires produisent sur des photos de paysage ou des clichés pris en intérieur. Pertinent sur la plupart des autres photos de chiens et sur certains fauves, ce « greffon » numérique prend mal sur les ours ou le chat, notamment. L’expérience n’en demeure pas moins intéressante du point de vue des chercheurs en IA.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

Crédit : NVIDIA

« La plupart des réseaux de transferts d’image basés sur les GANs (Generative Adversarial Networks, NDLR), sont entraînés pour effectuer des tâches simples, comme changer, sur une photo, un cheval en zèbre« , explique Ming -YU Liu, chercheur pour NVIDIA, dans un billet de blog relayé par Engadget. « Mais dans ce cas particulier, nous entraînons un réseau à résoudre plusieurs tâches de transformation à la fois. Il est ici nécessaire de transférer une source aléatoire vers une cible aléatoire. À la longue, le réseau apprend à généraliser pour transférer des animaux connus vers des animaux jamais vus auparavant. C’est de cette manière que nous réalisons des progrès en technologie et dans la société« , explique-t-il, « en résolvant des problèmes d’un genre nouveau« .

Pointons que si une belle marge d’amélioration est permise sur ce projet en particulier, NVIDIA et ses chercheurs en IA ont d’ores et déjà accouché d’outils assez remarquables d’un point de vue technique. C’est par exemple le cas de GauGAN, présenté pour la première fois en mars dernier.