Nombreuses sont les recherches qui suggèrent que des mouvements faciaux peuvent être synchronisés avec des pistes audio. À ce propos, une équipe de chercheurs de Microsoft s’est appuyée sur différents travaux existants pour développer une intelligence artificielle capable d’améliorer la fidélité des animations faciales.

Microsoft se perfectionne dans l’animation faciale

Les co-auteurs de cette recherche ont expliqué que : « comme nous le savons, la parole est criblée de variations. Nous pouvons prononcer un même mot avec des tonalités différentes, des durées variables, des accents spécifiques… Aussi, la parole est porteuse d’informations sur l’état émotionnel, l’identité et la personnalité de l’interlocuteur. L’intelligence artificielle que nous avons mis au point est la première approche du genre qui permet d’améliorer la performance du point de vue de l’apprentissage de la représentation audio ».

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

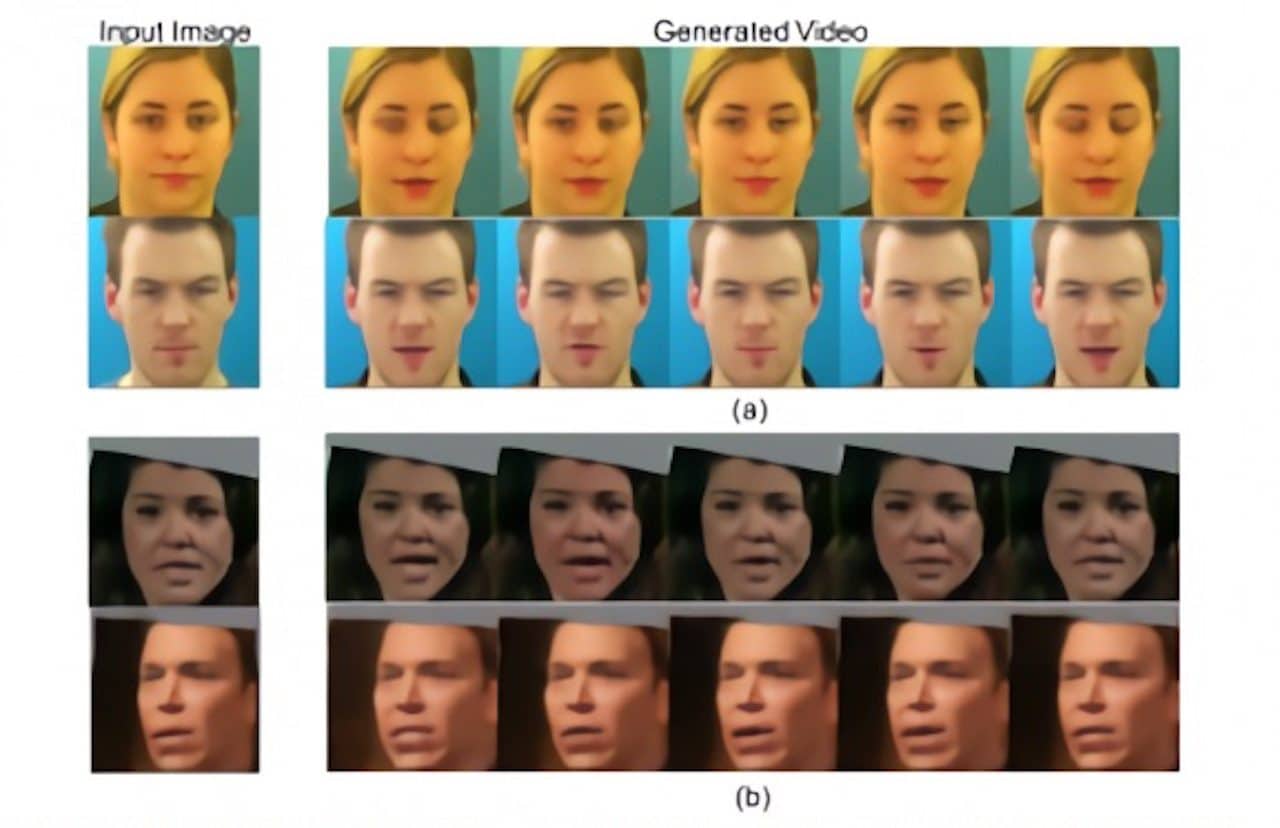

La technique proposée par les chercheurs de Microsoft repose sur un auto-encodeur variationnel, aussi appelé VAE, qui s’adapte au fur et à mesure des données récoltées. Les séquences audio sont transformées en contenu visible et retranscrites à travers les émotions et d’autres facteurs palpables sur les animations faciales générées. L’équipe de chercheurs affirme que cette méthode est capable d’offrir un rendement constant sur l’ensemble du spectre émotionnel et qu’elle est compatible avec toutes les approches de pointe existantes dans le domaine de l’animation faciale.

L’animation faciale par l’audio fascine

Les scientifiques américains de Microsoft se sont basés sur les nombreuses recherches effectuées à ce sujet. Notamment les travaux des chercheurs de l’Université de Carnegie Mellon, ceux de l’Université d’Udacity et des équipes travaillant sur l’intelligence artificielle chez Samsung. Ces derniers ont respectivement mis au point une approche pour transférer les mouvements faciaux d’une personne à une autre, un système qui génère automatiquement des vidéos montrant une personne debout, capable de parler uniquement à partir d’une narration audio. Enfin les derniers ont inventé un modèle capable d’animer les sourcils, la bouche, les cils et les joues d’une personne à partir de données audio.

Déjà en mai dernier, l’Université du Zhejiang en Chine et le Fuxi AI Lab de NetEase, avaient conjointement mis au point un système qui permet de générer une animation faciale à partir d’une piste audio. Leur intelligence artificielle nommée Audio2Face, s’efforce de respecter 2 critères principaux : les avatars doivent garder une certaine vivacité et s’adapter en temps réel. À ce propos, le système d’intelligence artificielle créé par cette équipe ne prend en moyenne, que 0,68 millisecondes pour extraire les données d’une piste audio, et la traduire en mouvements faciaux.