DeepMind, l’entreprise britannique spécialisée dans l’intelligence artificielle et rachetée par Google il y a quelques années, évolue à un rythme intéressant : elle est capable de jouer aux échecs, de devenir autodidacte et de modifier son comportement selon l’environnement dans lequel elle se trouve.

La filiale de Google a développé une machine qui a appris à imaginer une scène de différents points de vue à partir d’une simple image. Par exemple, si l’on utilise la photo d’un vase devant un mur, l’intelligence artificielle interprète les différents éléments, et imagine une version 3D de cette scène, en calculant les ombres et les zones de lumière.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

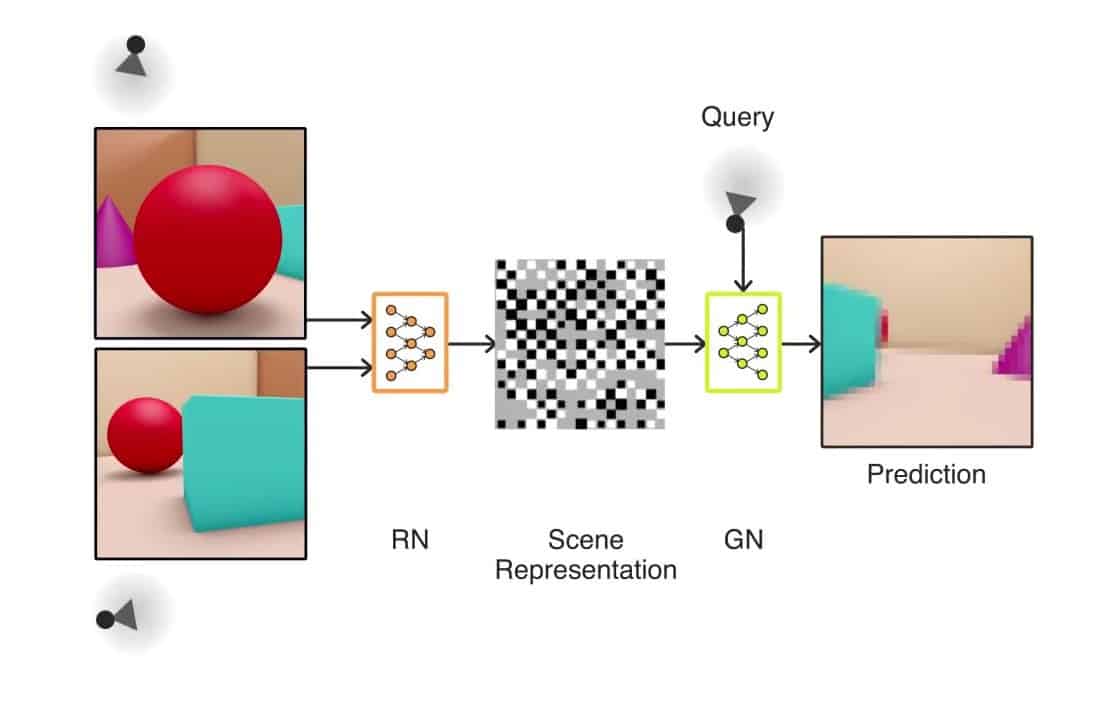

Ce système que l’on appelle Generative Query Network (GQN), comprend et analyse les différents détails d’une image en 2D, pour ensuite recréer les relations spatiale des objects, en fonction de l’environnement, comme la position de la caméra par exemple.

Ali Eslami, chercheur qui pilote ce projet chez Deepmind, explique que pour arriver à ce résultat, son équipe et lui-même ont dû intégrer au système une quantité d’images d’une même scène, mais sous différents angles. C’est de cette façon que la machine a appris à prédire la forme d’un object, à imaginer les textures, les couleurs et à gérer la luminosité.

Cette nouvelle compétence est impressionnante pour un robot, qui d’habitude observe son environnement et réagit en fonction de ce context en temps réel.

Le déploiement de ce système ne sera pas immédiat. Eslami précise que de plus grandes quantités de données et un hardware plus performant sont nécessaires pour perfectionner cette machine intelligente.