Les collaborations entre Google et MIT (Massachusetts Institute of Technology) sont fréquentes. Le premier étant un partenaire financier pour l’université et un vivier de futurs talents. Leurs travaux ont débouché sur un algorithme (et non une intelligence artificielle) permettant de retoucher instantanément une photographie prise avec son smartphone.

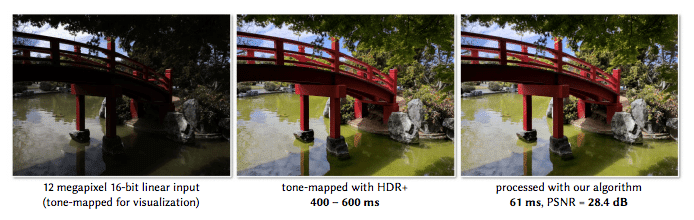

La photographie de droite est le résultat obtenu par l’algorithme développé versus la photographie originelle, et la version HDR+ (Imagerie à grande gamme dynamique – ndlr). Ce genre de prouesse fait souvent l’actualité avec les travaux d’Adobe, ceux de Google et à travers d’autres applications. Ici, la différence, c’est l’instantanéité de l’algorithme contrairement aux autres technologies. Celui développé par Google et le MIT s’appuie sur les travaux d’un étudiant qui ont permis d’économiser l’énergie nécessaire au rendu. En effet l’amélioration en temps réel demandait beaucoup trop d’énergie au téléphone. Ce qui peut s’avérer problématique pour un téléphone portable en utilisation prolongée.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

En termes d’application, l’algorithme reproduit les retouches HDR que nous connaissons actuellement et une simulation d’une retouche « humaine », enfin ce qui s’en rapprocherait le plus. Si cela est possible, c’est grâce au deep learning qui es une méthode d’apprentissage automatique utilisée dans la reconnaissance faciale ou encore vocale. Les GAFAs (dont le G de Google) réalise d’important investissements dans ce domaine depuis plusieurs années. On se souvient d’AlphaGo (de Google DeepMind) qui était le premier programme informatique a battre un joueur professionnel de go.

Si l’algorithme n’a pas encore d’application réelle au sein de nos smartphones, le futur prévoit pas mal de bouleversements pour les professionnels de la photographie et les technologies déployée.