Il ne se passe une semaine sans que l’on parle d’intelligence artificielle (IA). Mais comme le dit si bien Laurent Alexandre : « Vous mettez le tampon intelligence artificielle dessus, elle vaut tout de suite cinq fois plus chère (la technologie – ndlr). Il faudrait être très con pour ne pas mettre de l’intelligence artificielle partout, même lorsqu’il n’y en a pas… ». Mais là Google DeepMind a fait un pas de plus dans la recherche.

Pour ceux qui ne le seraient pas, Google DeepMind, c’est la filiale de Google spécialisée dans l’intelligence artificielle, créée en 2010 et basée à Londres. Dans une de leur publication scientifique, ils ont montré comment l’apprentissage par renforcement pouvait permettre à une IA d’évoluer dans un environnement inconnu et complexe. Je renvoie les lecteurs vers la page Wikipédia qui souhaiteraient en savoir plus sur cette notion d’apprentissage. Mais pour faire (très) simple, l’apprentissage par renforcement consiste à : un ensemble d’états du sujet (l’IA en l’occurence), un ensemble d’actions que le sujet peut effectuer et enfin un ensemble de valeurs dites « récompenses » que le sujet peut obtenir.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

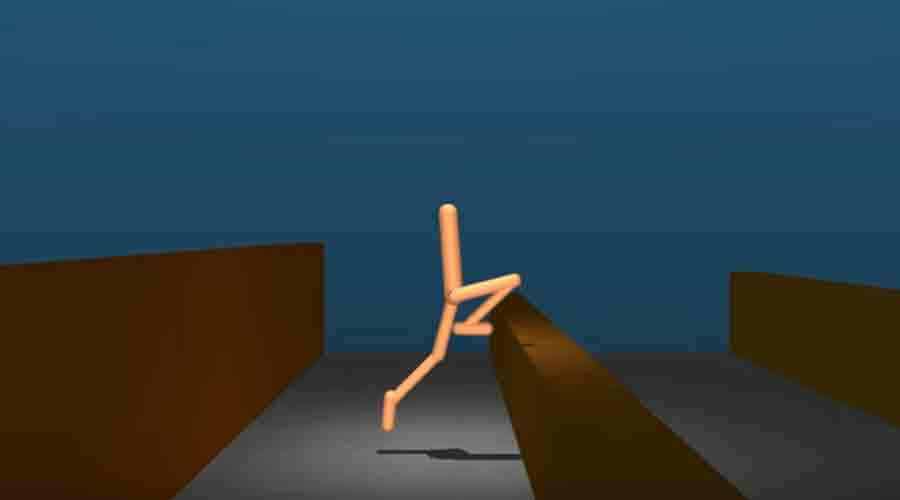

Après ce paragraphe théorique, voici les faits et les résultats de cette expérimentation. Google DeepMind a modélisé un personnage dans un environnement complexe, c’est-à-dire avec escaliers, des obstacles, etc. La prouesse de l’exercice a été de voir comment l’IA a réussi à surmonter ces derniers en adaptant sa gestuelle pour parvenir au bout de ceux-ci, comme utiliser son genou pour grimper :

Ce genre d’expérience nous montre à quel stade se situe l’intelligence artificielle dans l’appropriation de son environnement physique. On pourrait le comparer à un enfant en bas âge qui fait ses premiers et ses premières chutes. On imagine alors que d’ici quelques années, l’adolescence pointera son nez.