L’informatique quantique a longtemps été considérée comme l’une de ces technologies qui verra le jour dans 20 ans, mais 2017 pourrait être l’année de sa mise en service. Plus rapidement que nous le pensions ! Google, Microsoft et une myriade de laboratoires et start-ups sont en compétition pour transformer ces curiosités scientifiques en machine vraiment efficace.

Les géants informatiques (notamment Microsoft et Google) ont récemment embauché une foule d’ingénieurs, et ont fixé des objectifs ambitieux pour cette année. Leur ambition reflète une transition plus large pour les laboratoires de recherche académiques : de passer de la science pure vers l’ingénierie.

Inscrivez-vous à la newsletter

En vous inscrivant vous acceptez notre politique de protection des données personnelles.

« Les gens sont vraiment en train de construire des choses concrètes », dit Christopher Monroe, un physicien de l’Université du Maryland à College Park qui a co-fondé en 2015 la startup IonQ ; « Je n’ai jamais vu quelque chose comme ça. Ce n’est plus juste de la recherche. »

Google se rapproche d’un ordinateur quantique universel.

Google a commencé à travailler sur une forme d’ordinateur quantique qui exploite la supraconductivité en 2014. Elle espère cette année effectuer un calcul qui sera au-delà même des supercalculateurs les plus puissants. Un jalon insaisissable connu comme la suprématie quantique. Son rival, Microsoft, parie sur un concept intéressant mais non prouvé : ordinateur quantique topologique. Il espère effectuer très prochainement sa première démonstration.

La scène de l’informatique quantique est en train de chauffer. Le Professeur Monroe prévoit d’embaucher pour de bon cette année. Le physicien Robert Schoelkopf à l’Université de Yale (qui a co-fondé le Quantum Circuits) et l’ancien d’IBM en physique appliquée Tchad Rigetti (qui a créé Rigetti à Berkeley en Californie) disent tous deux qu’ils vont atteindre des jalons techniques cruciaux très prochainement.

« Nous avons démontré tous les composants et toutes les fonctions dont nous avons besoin, » dit M. Schoelkopf, qui gère un groupe d’ingénieurs pour construire un ordinateur quantique. Bien que beaucoup d’expériences en physique doivent encore être fait pour obtenir des composants nécessaires ; les principaux défis sont maintenant en ingénierie. L’ordinateur quantique avec le plus de qubits jusqu’à présent – 20 – est testé dans un laboratoire universitaire dirigé par Rainer Blatt à l’Université d’Innsbruck en Autriche.

La différence entre bit et qubit ?

Un bit classique se trouve toujours soit dans l’état 0, soit dans l’état 1. Un qubit (prononcé /kyoobit/) peut quant à lui être soit dans l’état 0, soit dans l’état 1, soit dans une superposition de 0 et 1. Mais ce n’est pas un troisième état, c’est une infinité d’autres états (le reste est mathématique et physique je n’entrerai pas dans les détails). Ceci, est la capacité des qubits de partager un état quantique appelé l’intrication. Grâce à cette fonction, cela devrait permettre aux ordinateurs d’effectuer de nombreux calculs à la fois. Ainsi, le nombre de ces calculs doit, en principe, doubler pour chaque qubit supplémentaire, conduisant à une accélération exponentielle.

Pour se donner une idée.

Avec 10 qubits, on a 1024 états superposables, et avec n qubits, 2n. Donc, quand un opérateur est appliqué à l’ensemble des qubits, il est appliqué à 2n états en même temps, ce qui équivaut à un calcul parallèle sur 2n données en même temps ! Par exemple 11 qubits on a 211 soit 2048 états superposables. C’est pourquoi la puissance de calcul théorique d’un ordinateur quantique double à chaque fois qu’on lui adjoint un qubit.

Des champs d’applications scientifiques.

Cette rapidité devrait permettre aux ordinateurs quantiques d’effectuer certaines tâches ; telles que la recherche de grandes bases de données (Big Data) ou la factorisation de grands nombres. Les machines pourraient également être transformationnel. C’est-à-dire comme un outil de recherche, il effectuera des simulations quantiques qui permettraient aux chimistes de comprendre les réactions avec des détails sans précédent. Ou bien à des physiciens de concevoir des matériaux supraconducteurs à température ambiante.

Comment ça fonctionne ?

Il y a beaucoup de propositions concurrentes sur la façon de construire des ordinateurs quantiques. Mais il y en a deux en tête, confirmés dans leur capacité à stocker des informations de plus en plus longues. En dépit de la vulnérabilité des états quantiques et aux perturbations externes, permettent d’effectuer des opérations de logiques quantiques. Une approche adoptée par M. Schoelkopf et M. Rigetti (IBM), impliquant le codage des états quantiques sous forme de courants oscillants dans des boucles supraconductrices. L’autre, poursuivie par Pr. Monroe et plusieurs grands laboratoires universitaire ; est de coder les qubits en ions simples détenus par des champs électriques et magnétiques dans des pièges à vide.

John Martinis, qui a travaillé à l’Université de Californie, jusqu’à ce que Google engage lui et son groupe de recherche en 2014. Il affirme que la maturité de la technologie supraconductrice a amené son équipe à établir le but audacieux de la suprématie quantique.

L’équipe prévoit d’atteindre cet objectif en utilisant un algorithme « chaotique » quantique qui produit ce qui ressemble à une sortie aléatoire. (cf. S. Boixo et al. Preprint à https://arxiv.org/abs/1608.00263; 2016). L’équipe dit que si l’algorithme est exécuté sur un ordinateur quantique constitué de peu de qubits, une machine classique peut aussi prédire sa sortie. Mais une fois que la machine quantique se rapproche à environ 50 qubits, même les plus grands supercalculateurs classiques ne parviennent pas à suivre le rythme.

Quantum Circuits fait la première simulation de physique des hautes énergies

La suprématie quantique.

Les résultats du calcul n’auront aucune utilité, mais ils démontreront qu’il existe des tâches pour lesquelles les ordinateurs quantiques sont imbattables. Un seuil psychologique important qui attirera l’attention des clients potentiels. « Nous pensons que ce sera une expérience séminale » dit M. Martinis.

Mais M. Schoelkopf ne voit pas la suprématie quantique comme « un but très intéressant ou utile ». En partie parce qu’elle esquive le défi de la correction d’erreur : la capacité du système à récupérer ses informations après de légères perturbations aux qubits. Ce qui devient plus difficile à mesure plus le nombre de qubits augmente. Au lieu de cela, Quantum Circuits se concentre sur la fabrication de machines entièrement corrigées par erreur dès le début. Cela nécessite de construire plus de qubits, mais les machines pourraient également exécuter des algorithmes quantiques plus sophistiqués.

M. Monroe espère atteindre la suprématie quantique bientôt, mais qui n’est pas le but principal de IonQ. La start-up vise à construire des machines qui ont 32 ou même 64 qubits. Avec la technologie « ion-trap » permettra des conceptions plus flexible et évolutive que les circuits supraconducteurs, assure-t-il.

Microsoft, quant à lui, parie sur la technologie qui a le plus à prouver. Le calcul quantique topologique dépend des excitations de la matière qui encodent l’information en s’emmêlant l’une autour de l’autre comme des tresses. Les informations contenues dans ces qubits seraient beaucoup plus résistantes aux perturbations extérieures que les autres technologies et faciliteraient notamment la correction des erreurs.

L’article nous apprend un nouveau dénominateur dans le vaste monde de l’Intelligence Artificielle, celui du reinforcement learning, la capacité à l’ordinateur de s’autocorriger. L’avènement des ordinateurs quantiques va transformer l’informatique dans le sens général. D’une part par sa puissance de calcul phénoménal mais aussi pour la capacité à renforcer ses propres connaissances, en quelque sorte ça sera AlphaGo mais puissance n million !

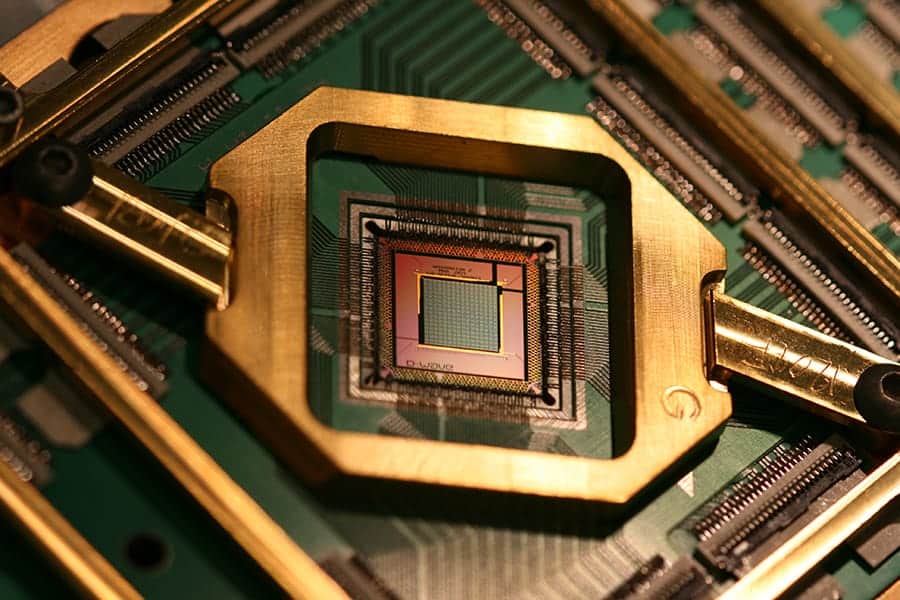

l’ordinateur quantique de Google

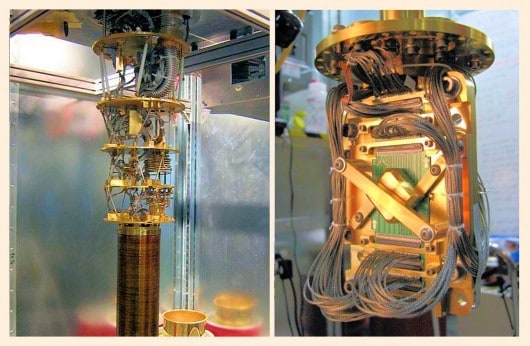

l’ordinateur quantique D-Wave